模型接入

接入 AWS Bedrock 上的模型

功能介绍

AWS Bedrock Marketplace 是一个综合的 LLM 部署平台,开发人员可以在该平台发现、测试和使用 100 多种常用的新兴专业基础模型(FM)并轻松部署与访问。 本文将以部署 DeepSeek 模型为例,演示如何在 Bedrock Marketplace 平台部署模型并集成至 Dify 平台,帮助你快速搭建基于 DeepSeek 模型的 AI 应用。前置准备

- 拥有 Bedrock 访问权限的 AWS 账号

- Dify.AI 账号

开始部署

1. 部署 DeepSeek 模型

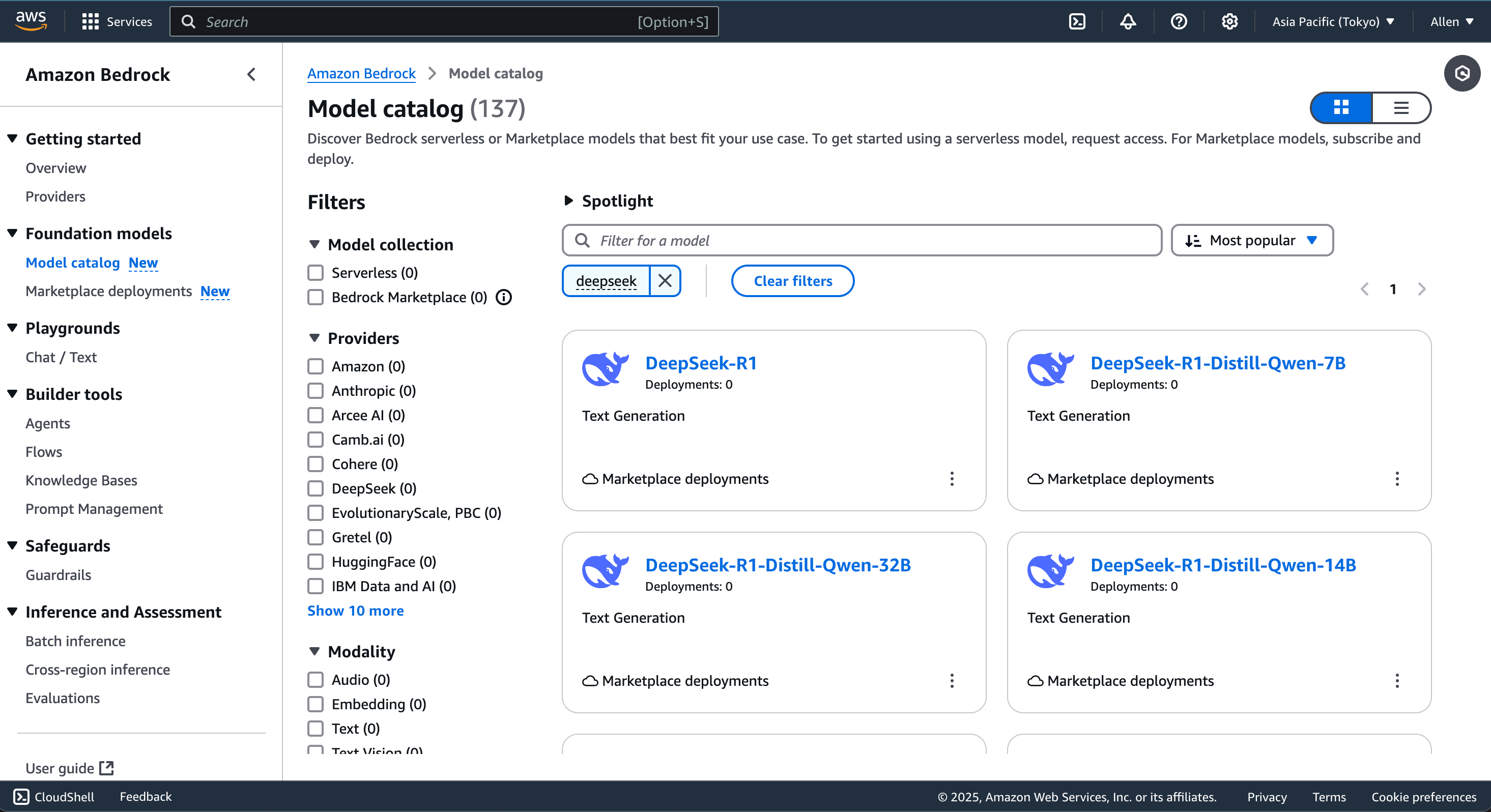

1.1 在 Bedrock Marketplace 中搜索 DeepSeek,选择任意一个 DeepSeek R1 及其蒸馏版本的模型。 1.2 进入模型详情页,点击 “Deploy” 并按照页面提示填写相关信息,完成一键部署。

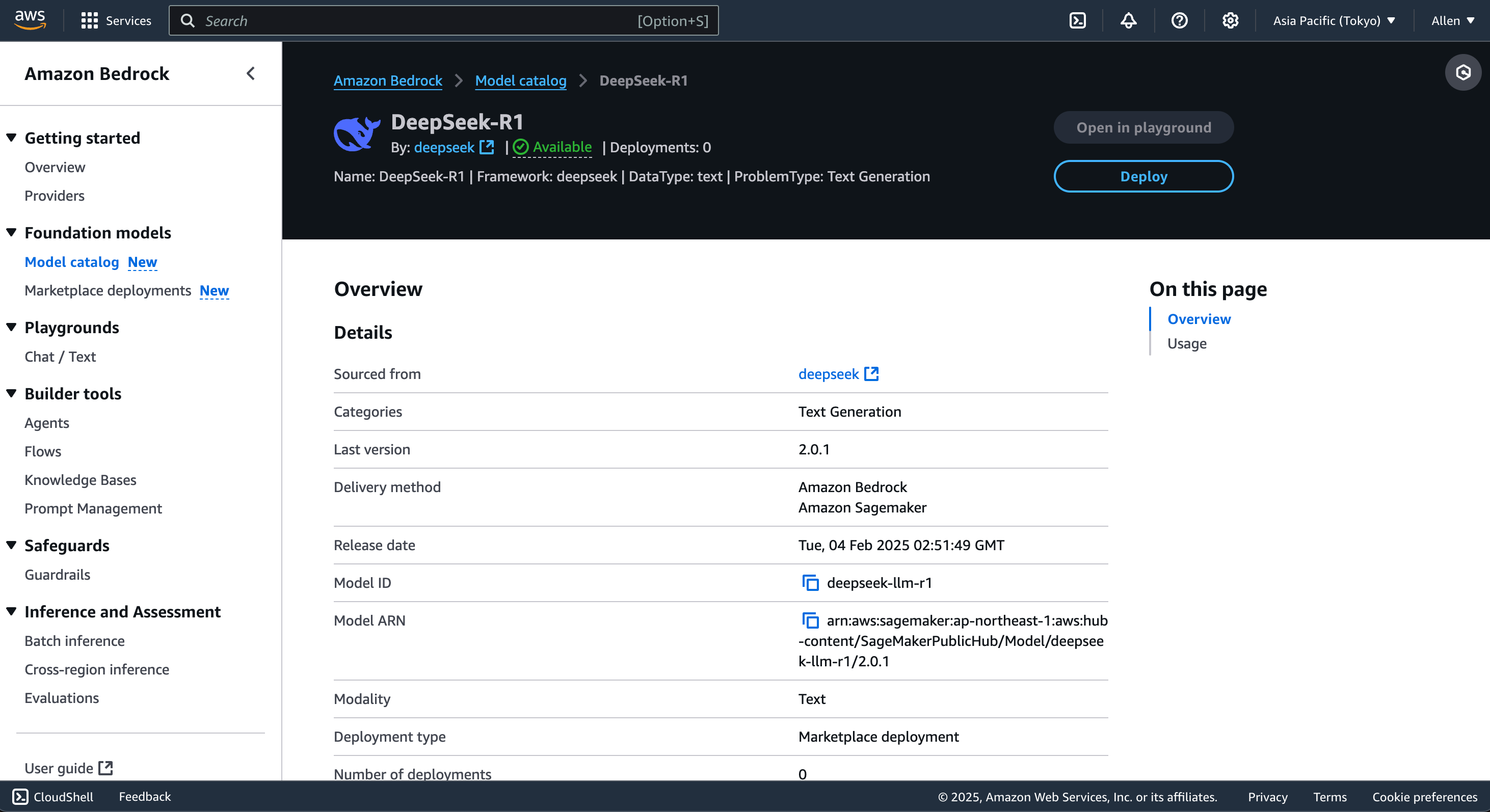

1.2 进入模型详情页,点击 “Deploy” 并按照页面提示填写相关信息,完成一键部署。

请注意,不同版本的模型可能要求不同的计算实例配置,费用有所差异。

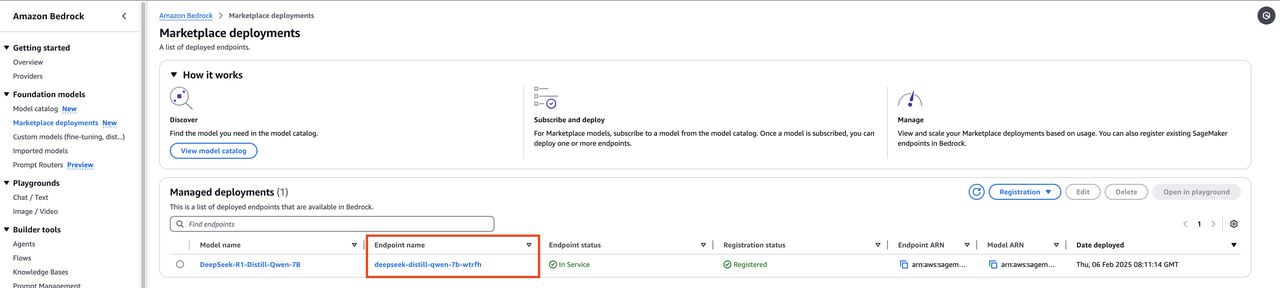

1.3 部署完成后,你可以在 Marketplace Deployments 页查看自动生成的 Endpoint,该参数与 SageMaker Endpoint 参数相同,将用于后续 Dify 平台的连接。

1.3 部署完成后,你可以在 Marketplace Deployments 页查看自动生成的 Endpoint,该参数与 SageMaker Endpoint 参数相同,将用于后续 Dify 平台的连接。

2. 建立 DeepSeek 模型与 Dify 平台的连接

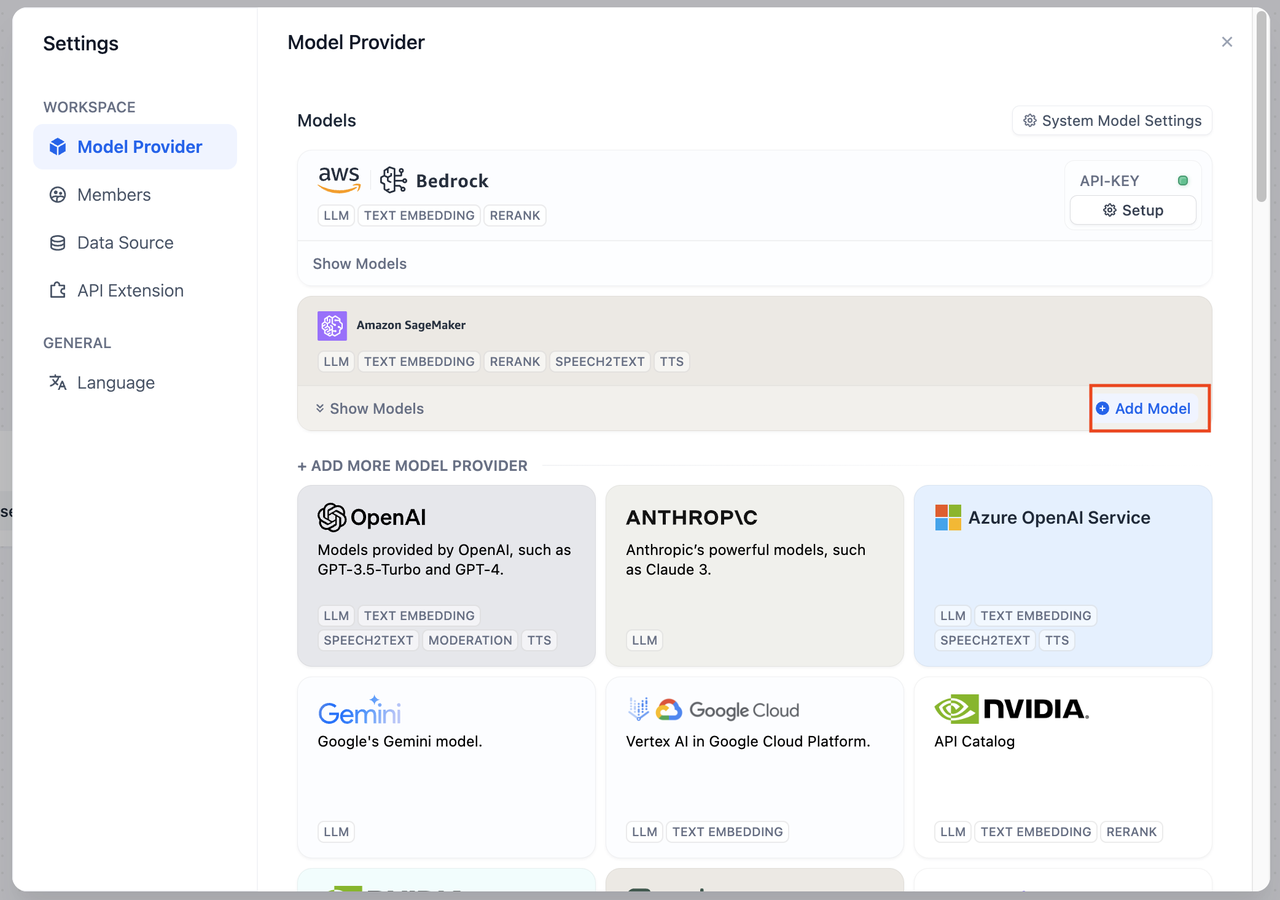

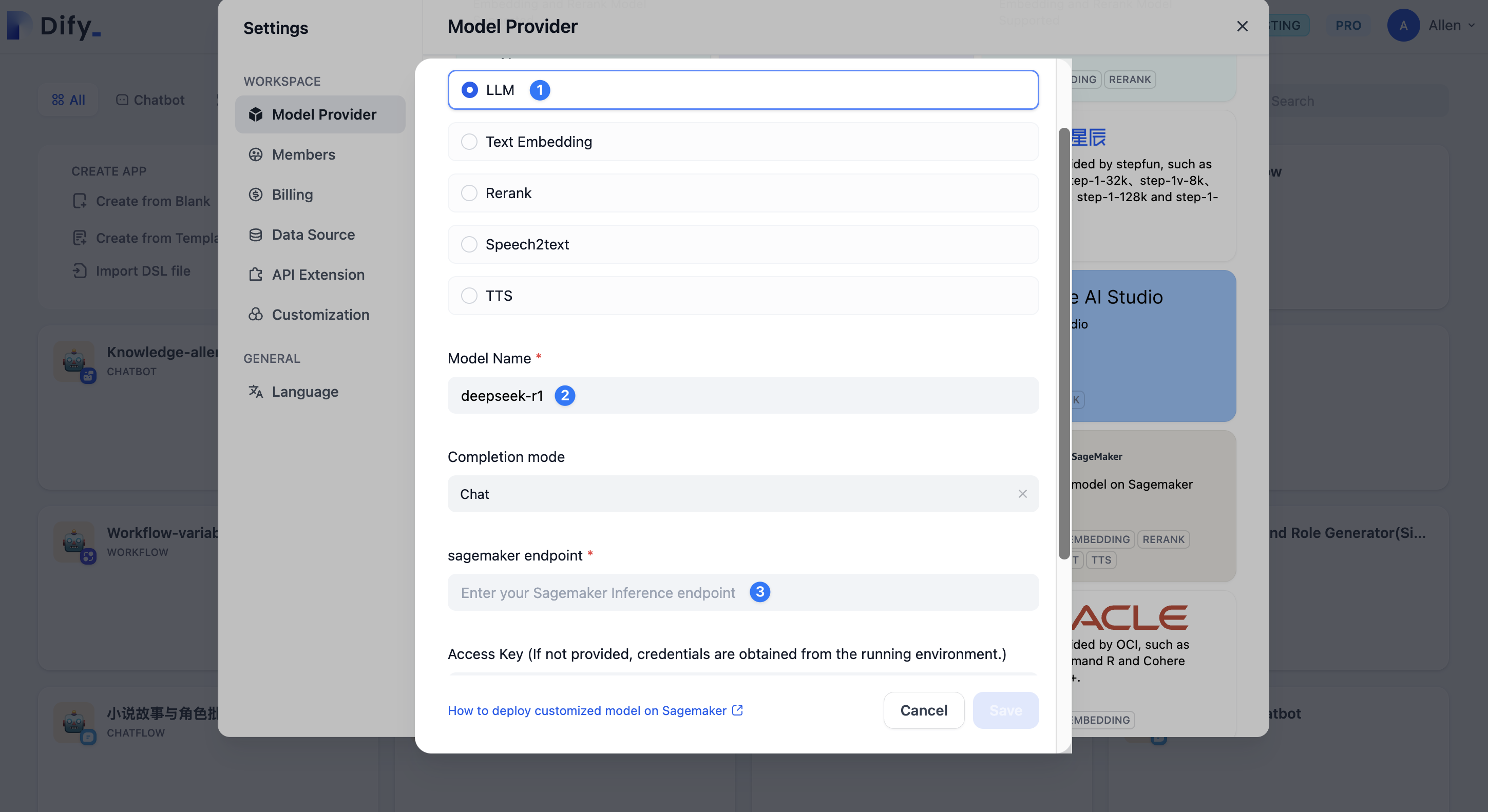

2.1 进入 Dify 管理面板,打开 Settings 页面。 2.2 在 Model Provider 选项中找到 SageMaker,并点击 SageMaker 卡片右下角的 “Add Model” 进入配置页面。 2.3 进入 SageMaker 配置页面,参考以下内容进行填写。

2.3 进入 SageMaker 配置页面,参考以下内容进行填写。

- Model Type: 模型类型,选择 LLM 类型

- Model Name:模型名称,可自定义填写

- sagemaker endpoint:填写在上文中提及的 Endpoint 参数。该参数可以在 AWS Bedrock Marketplace 中的 Endpoint 页获取。

- Marketplace Deployments 页查看自动生成的 Endpoint,

3. 运行模型

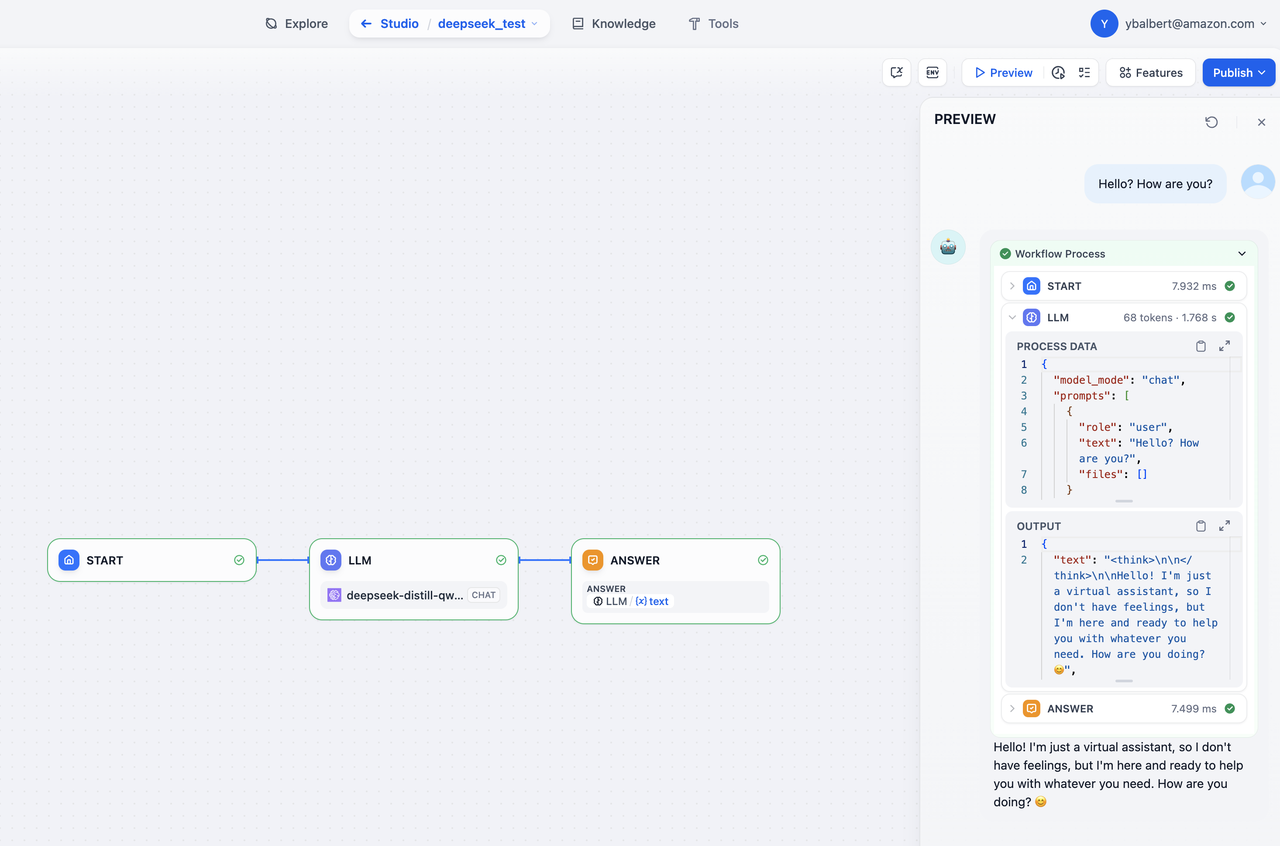

配置完成后,你可以在 Dify 平台内测试 DeepSeek 模型是否能够正常运行。轻点 Dify 平台首页左侧的”创建空白应用”,选择 「Chatflow 或 Workflow」类型应用并添加 LLM 节点。 参考以下截图,在应用预览页测试模型是否能够正常给出答复。 除了使用 Chatflow / Workflow 应用类型进行测试以外,你还可以创建 Chatbot 类型应用进行测试。

除了使用 Chatflow / Workflow 应用类型进行测试以外,你还可以创建 Chatbot 类型应用进行测试。

常见问题

1. 部署后没有看到 Endpoint 参数?

确保已正确配置实例,并检查 AWS 权限设置是否正确。如果仍有问题,尝试重新部署或咨询 AWS 客户支持人员。编辑此页面 | 提交问题