⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、英語版を参照してください。

クイックスタート

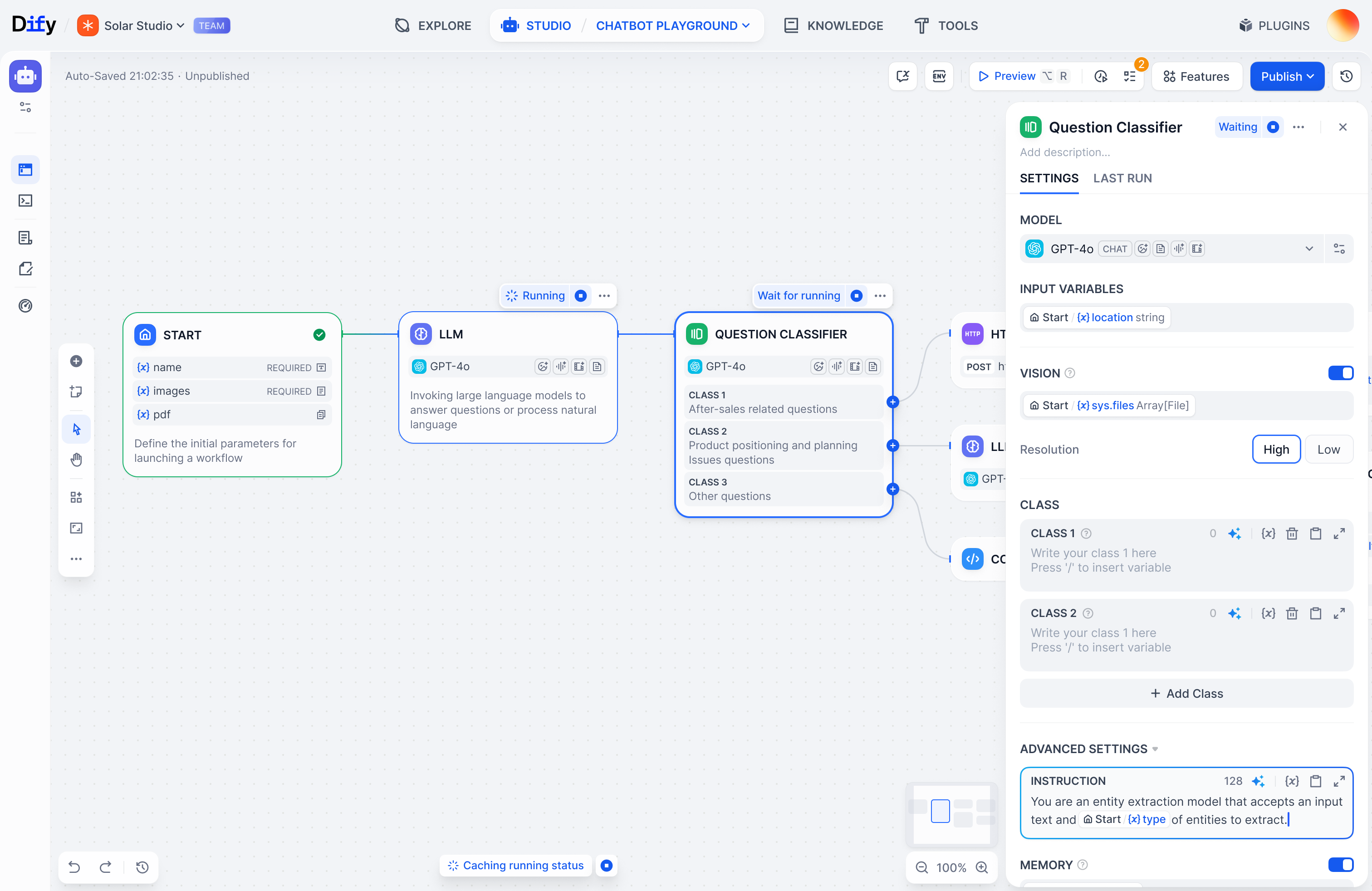

数分で強力なアプリの構築を開始

概念

Difyの核となる構成要素の説明

セルフホスティング

自分のノートパソコン/サーバーにDifyをインストールするガイド

フォーラム

コミュニティとの情報交換

変更履歴

過去のリリースでの変更内容

チュートリアル

Difyのユースケース例のウォークスルー

Difyという名前は、Do It For You(あなたのためにそれを行う)に由来しています。