⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、英語版を参照してください。

システムプロバイダー vs カスタムプロバイダー

システムプロバイダーはDifyによって管理されます。セットアップなしでモデルに即座にアクセスでき、Difyサブスクリプションを通じて請求され、新しいモデルが利用可能になると自動的に更新されます。迅速に開始するのに最適です。 カスタムプロバイダーは、OpenAI、Anthropic、Googleなどのモデルプロバイダーに直接アクセスするために独自のAPIキーを使用します。完全な制御、直接請求、多くの場合より高いレート制限を得られます。本番アプリケーションに最適です。 両方を同時に使用できます—プロトタイピングにはシステムプロバイダー、本番にはカスタムプロバイダーを使用できます。カスタムプロバイダーの設定

ワークスペースの管理者とオーナーのみがモデルプロバイダーを設定できます。プロセスはプロバイダー間で一貫しています:サポートされているプロバイダー

大規模言語モデル:- OpenAI (GPT-4, GPT-3.5-turbo)

- Anthropic (Claude)

- Google (Gemini)

- Cohere

- Ollama経由のローカルモデル

- OpenAI Embeddings

- Cohere Embeddings

- Azure OpenAI

- ローカル埋め込みモデル

- 画像生成 (DALL-E, Stable Diffusion)

- 音声 (Whisper, ElevenLabs)

- モデレーションAPI

プロバイダー設定例

- OpenAI

- Anthropic

- ローカル (Ollama)

必須: OpenAI PlatformのAPIキーオプション: Azure OpenAIまたはプロキシ用のカスタムベースURL、組織スコープ使用のための組織ID利用可能なモデル: GPT-4, GPT-3.5-turbo, DALL-E, Whisper, テキスト埋め込み

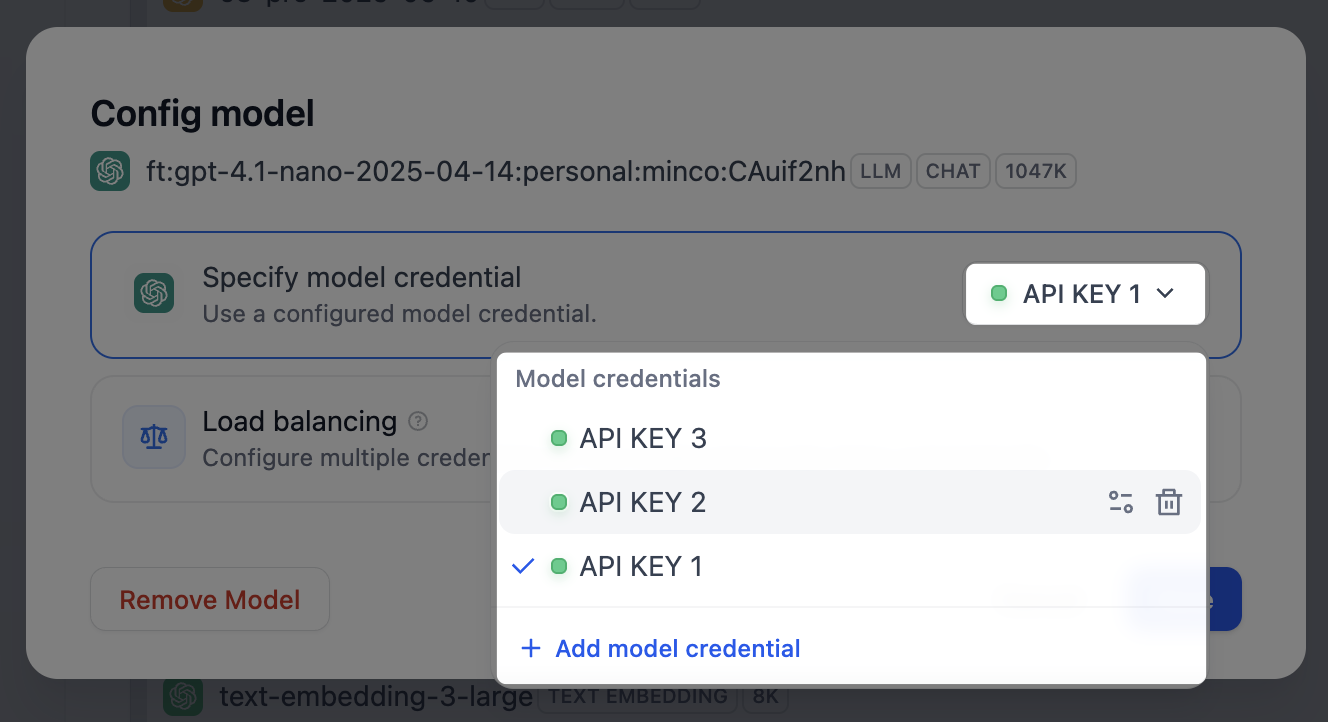

モデルの認証情報を管理

モデルプロバイダーの定義済みモデルやカスタムモデルに対して、複数の認証情報を追加し、それらの認証情報の切り替え、削除、変更を簡単に行うことができます。 以下のシナリオでは、複数のモデル認証情報を追加することをお勧めします。- 環境の分離: 開発、テスト、本番など、環境ごとに別々のモデル認証情報を設定します。例えば、開発環境ではデバッグ用にレート制限のある認証情報を使用し、本番環境ではサービスの品質を確保するために、安定したパフォーマンスと十分なクォータを持つ有料の認証情報を使用します。

- コストの最適化: 異なるアカウントやモデルプロバイダーから複数の認証情報を追加して切り替えることで、無料または低コストのクォータを最大限に活用し、アプリケーションの開発・運用コストを削減します。

- モデルのテスト: モデルのファインチューニングやイテレーションの過程で、複数のモデルバージョンを作成することがあります。これらの異なるバージョンの認証情報を追加することで、素早く切り替えてパフォーマンスのテストや評価を行うことができます。

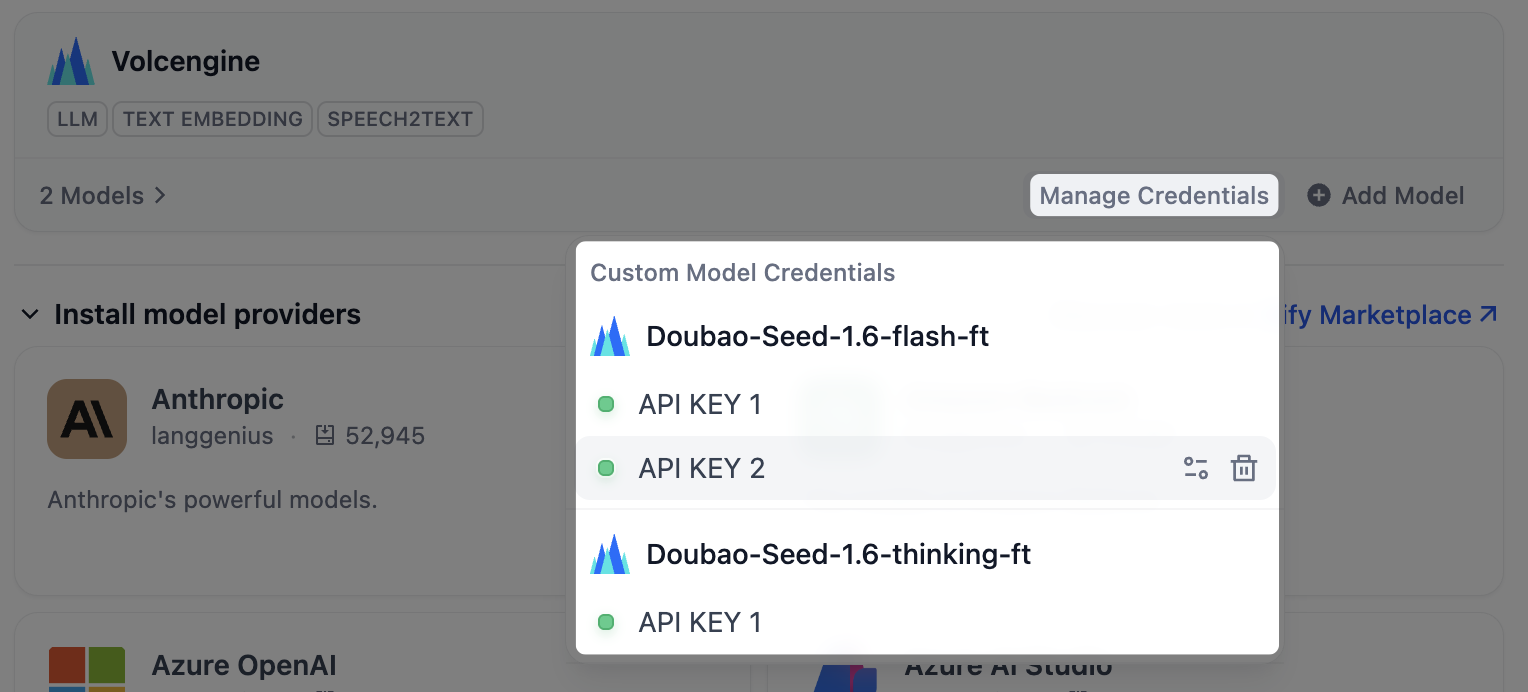

- 定義済みモデル

- カスタムモデル

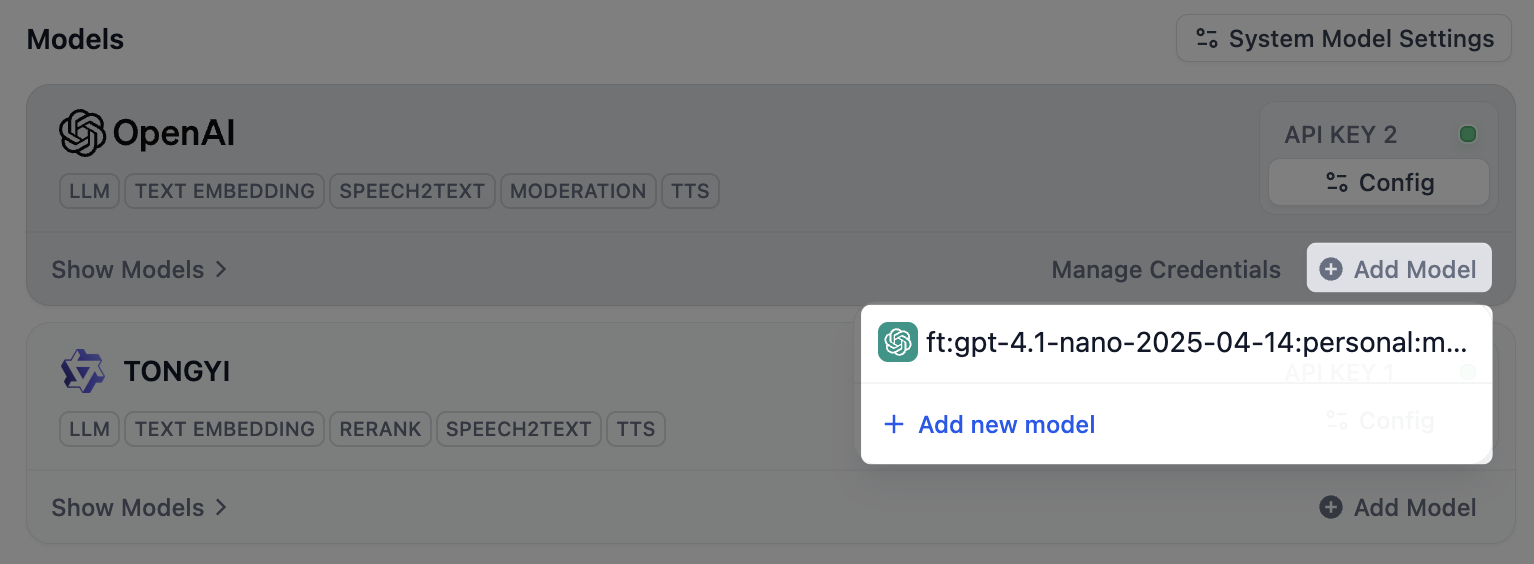

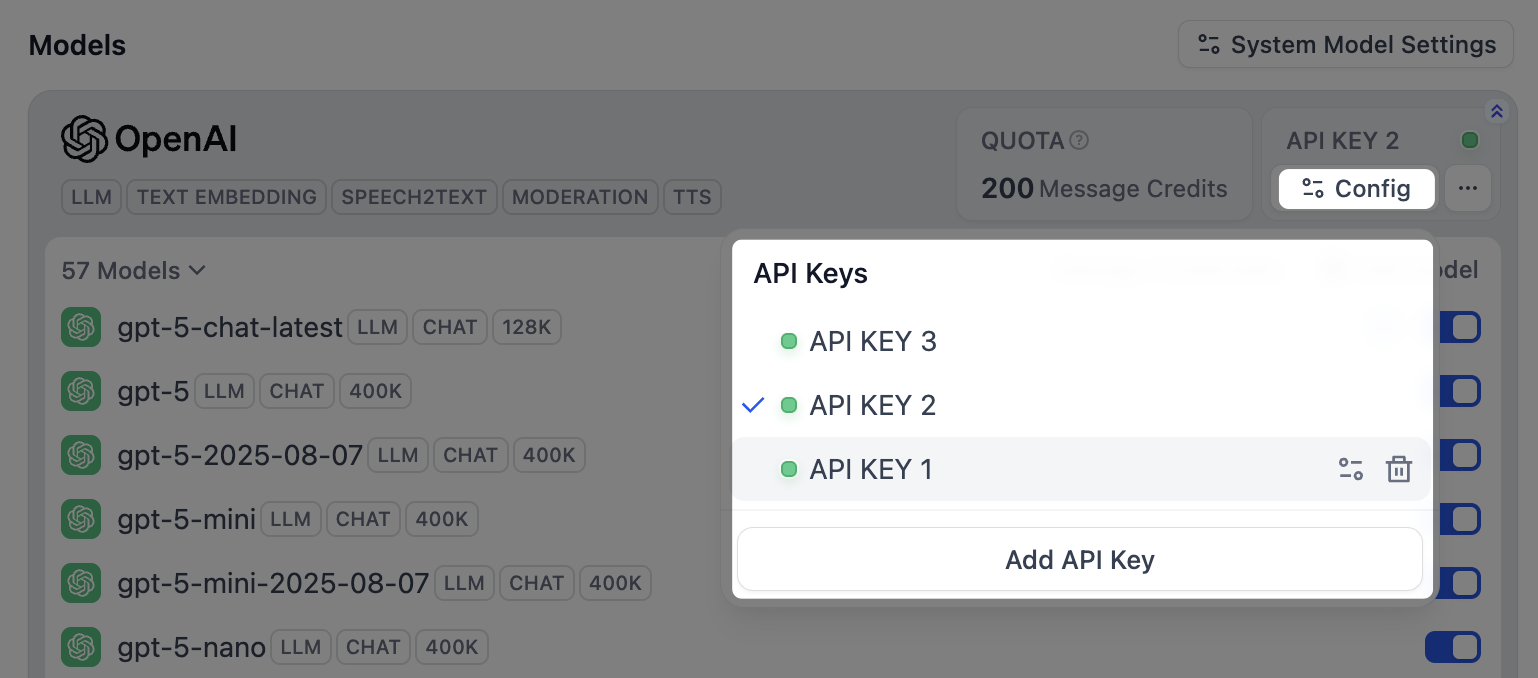

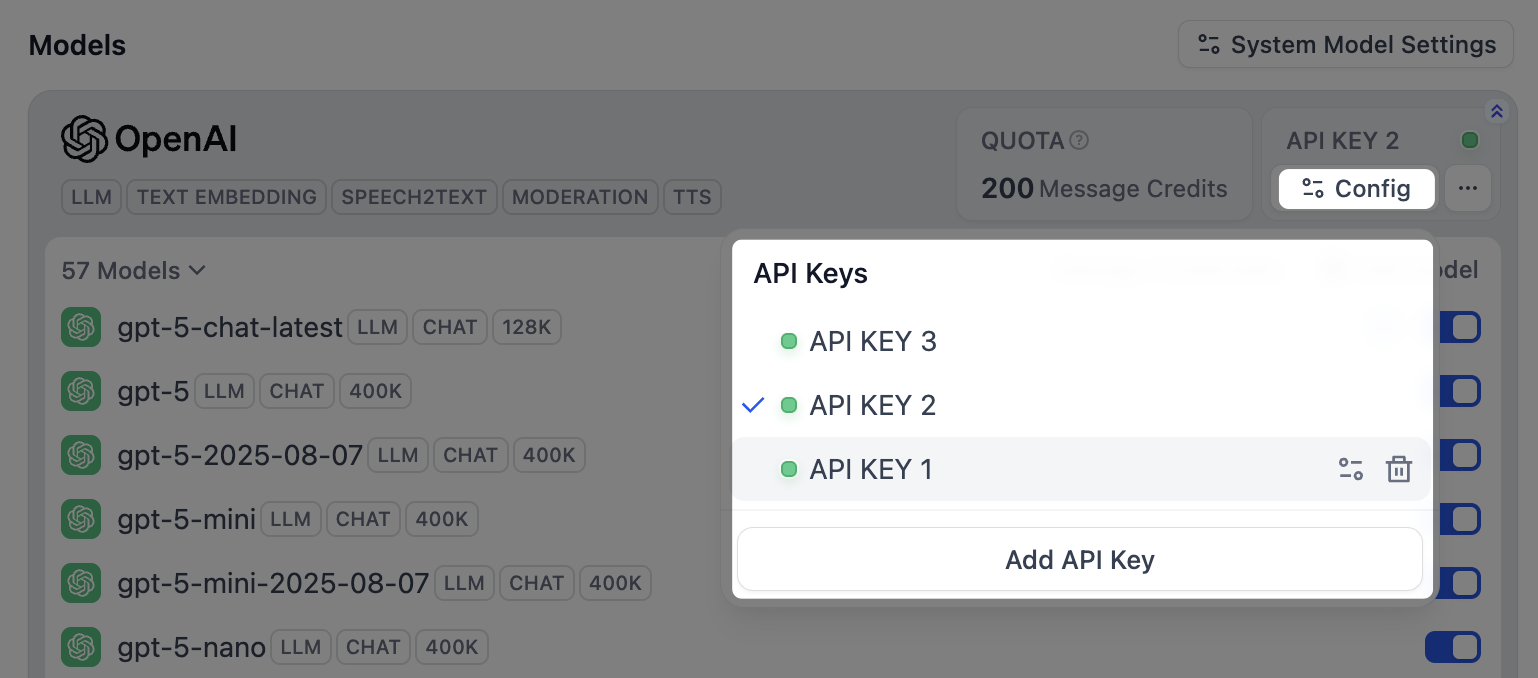

モデルプロバイダーをインストールして最初の認証情報を設定した後、右上の コンフィグ をクリックして、以下の操作を実行します。

- 新しい認証情報を追加する

- すべての定義済みモデルのデフォルトとして認証情報を選択する

- 認証情報を編集する

- 認証情報を削除する

デフォルトの認証情報を削除した場合は、手動で新しい認証情報を指定する必要があります。

モデルのロードバランシングを設定

ロードバランシングは有料機能です。SaaS有料プランのサブスクリプションまたはエンタープライズ版の購入によって有効化できます。

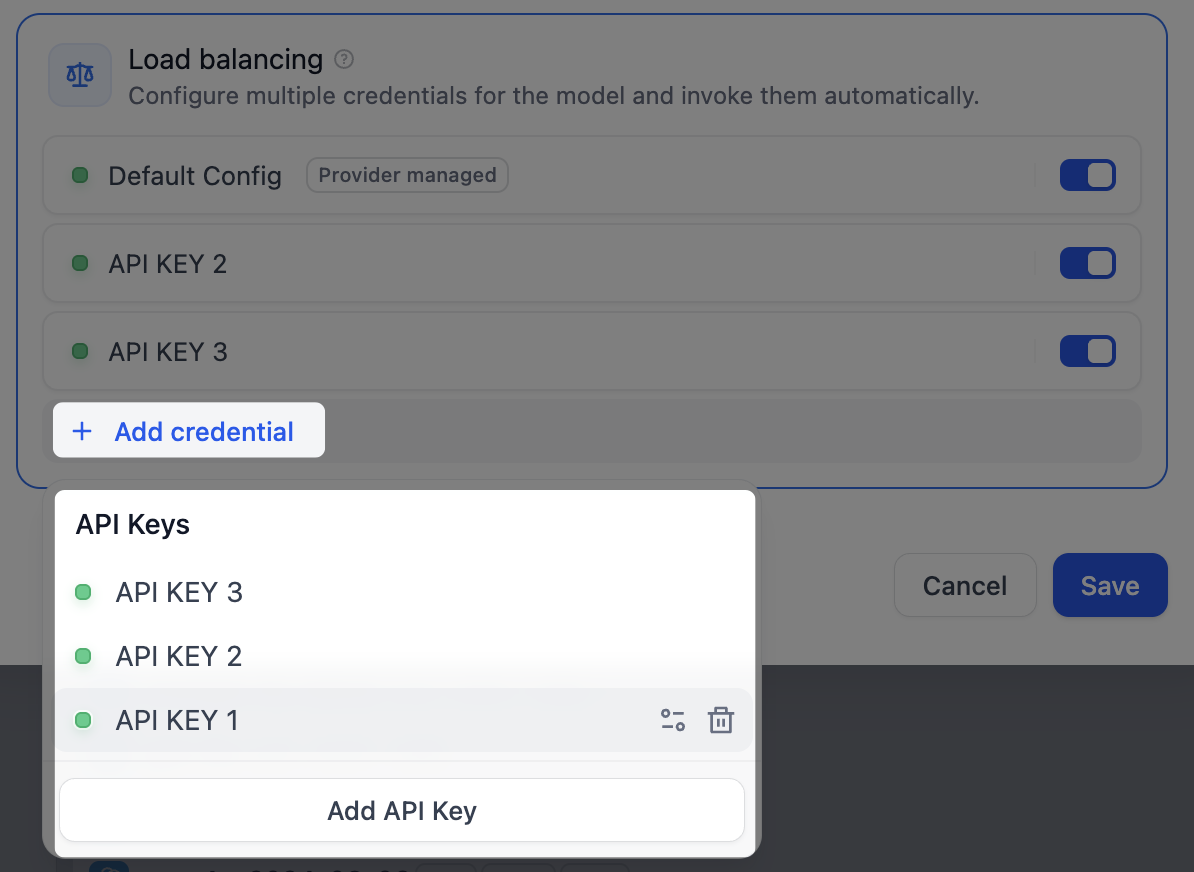

- モデルリストで対象のモデルを探し、対応する コンフィグ をクリックして 負荷分散 を選択します。

-

ロードバランシングプールで 認証情報を追加する をクリックし、既存の認証情報を選択するか、新しい認証情報を追加します。

デフォルトの設定 は、そのモデルに現在指定されているデフォルトの認証情報を指します。

-

負荷分散プールで少なくとも2つの認証情報を有効にし、保存 をクリックします。負荷分散が有効になったモデルには、特別なアイコンが表示されます。

ロード バランシング モードからデフォルトの単一認証情報モードに戻しても、ロード バランシングの設定は将来の使用のために保持されます。

アクセスと請求

システムプロバイダーはDifyサブスクリプションを通じて請求され、プランに基づく使用制限があります。カスタムプロバイダーはプロバイダー(OpenAI、Anthropicなど)を通じて直接請求され、多くの場合より高いレート制限を提供します。 チームアクセスはワークスペース権限に従います:- オーナー/管理者はプロバイダーを設定、修正、削除できます

- エディター/メンバーは利用可能なプロバイダーを表示し、アプリケーションで使用できます