⚠️ このドキュメントはAIによって自動翻訳されています。不正確な部分がある場合は、英語版を参照してください。

ツールの種類

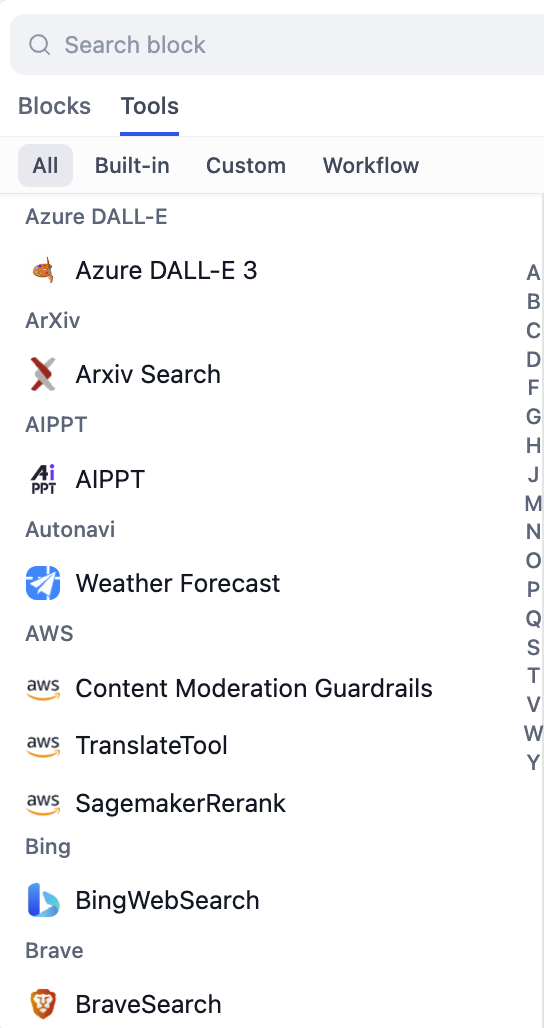

Difyは、さまざまな統合ニーズに対応するため、複数のタイプのツールをサポートしています:

- 組み込みツール

- カスタムツール

- ワークフローツール

- MCPツール

Google検索、天気API、生産性ツール、AIサービスなどの人気サービス向けに、Difyが管理する、すぐに使用できる統合。これらのツールは最小限の設定で、信頼性があり、テスト済みの統合を提供します。

設定

認証

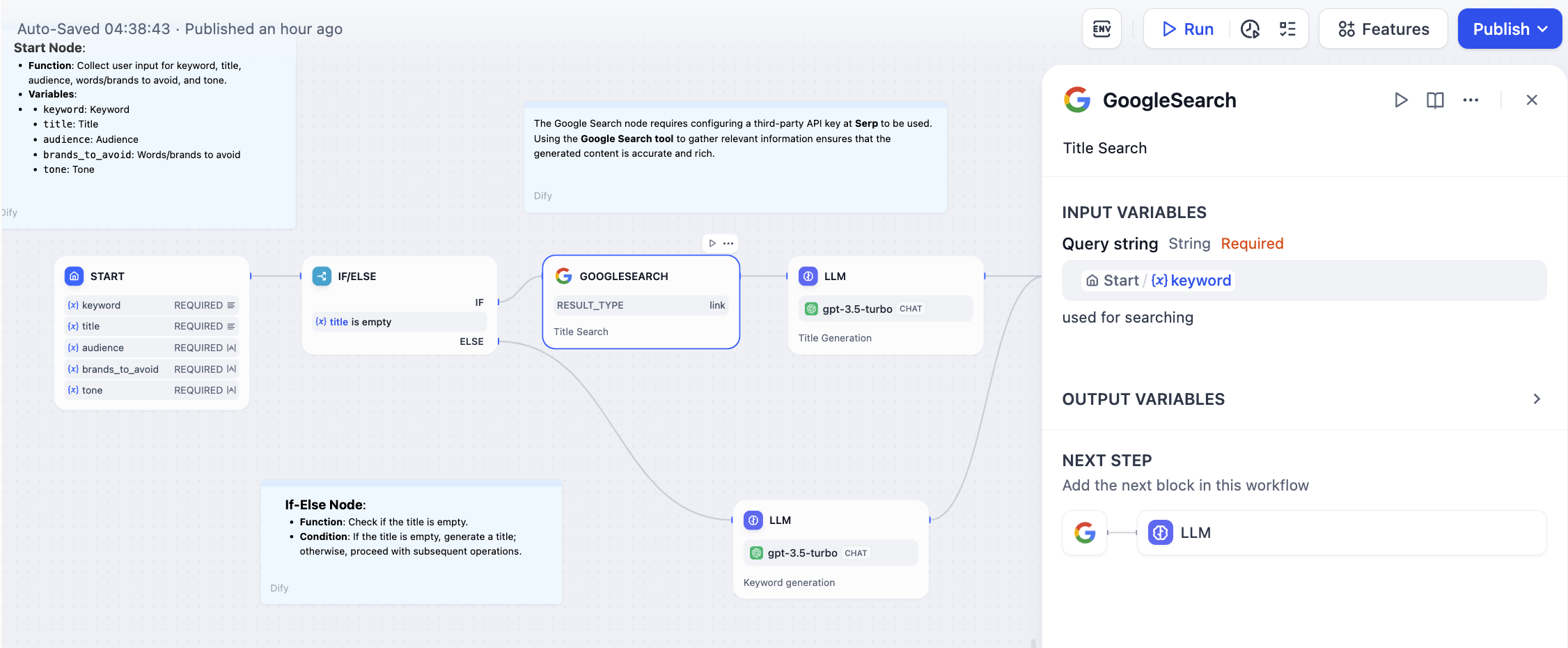

多くのツールはAPIキーまたはOAuth認証を必要とします。ワークフローで使用する前に、ワークスペースのツールセクションでこれらの認証情報を設定してください。認証は一度設定すれば自動的に処理されます。入力パラメータ

ツールは、入力設定のための検証付き構造化フォームを提供します。前のワークフローノードからの変数を使用してパラメータを設定します。インターフェースは自動的にデータタイプの検証を処理し、各パラメータに役立つ説明を提供します。出力処理

ツールは構造化されたデータを返し、これが下流のノードで変数として利用可能になります。出力スキーマは事前定義されており、互換性を確保し、統合の複雑さを軽減します。HTTPリクエストに対する利点

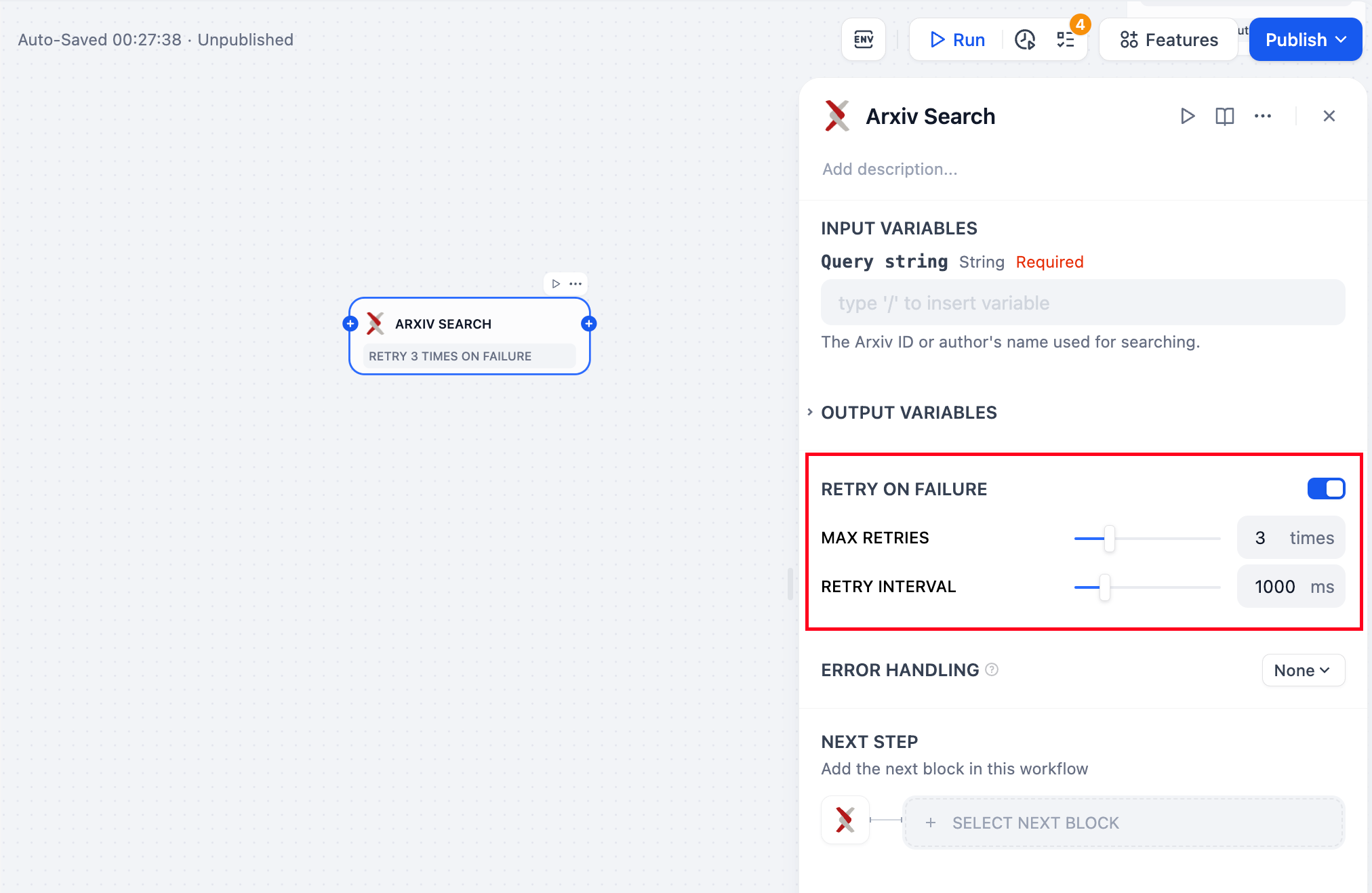

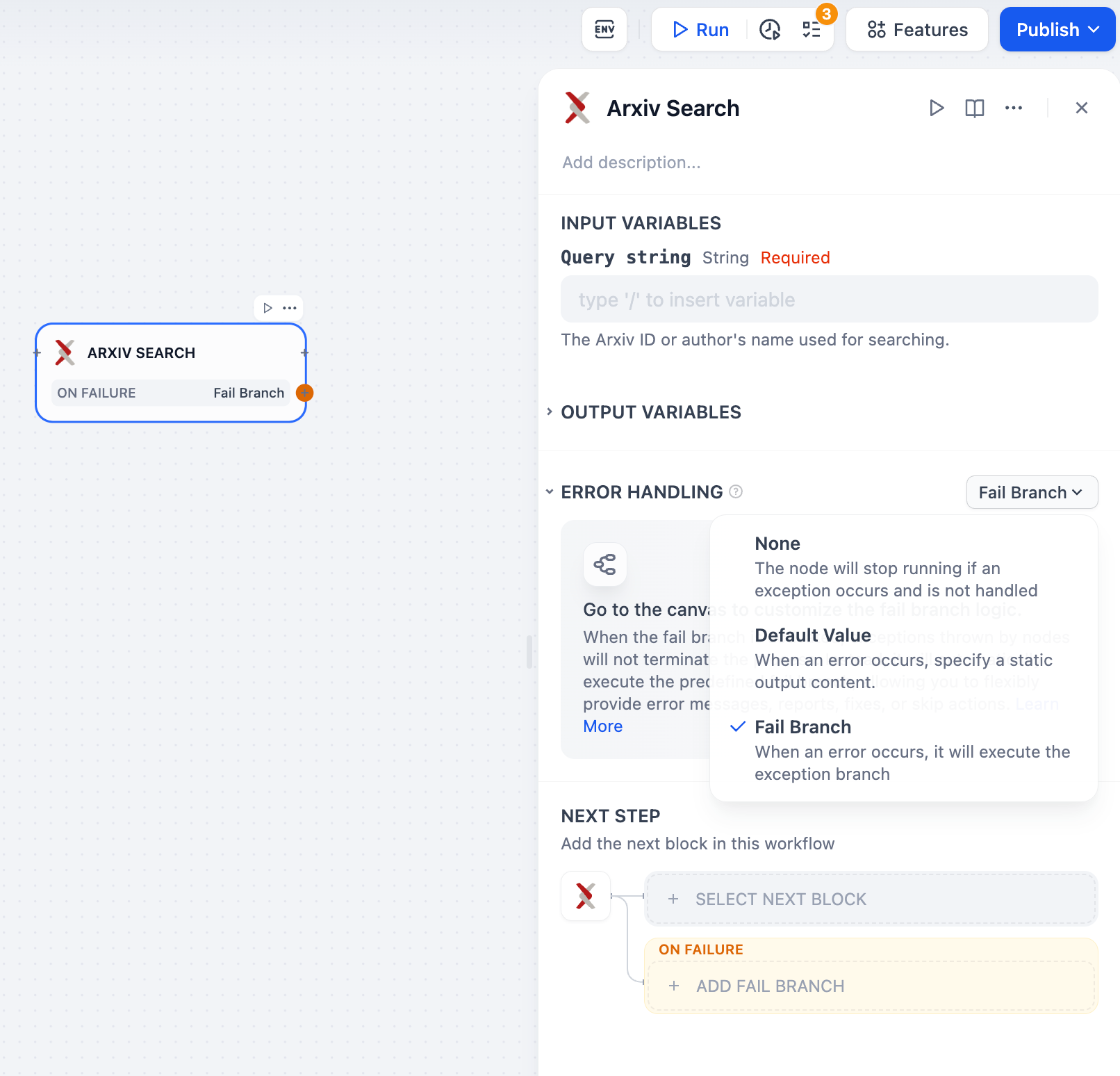

構造化されたインターフェースは、組み込み検証を備えたフォームベースの設定を提供し、手動でのHTTPリクエスト設定よりもセットアップを簡単にします。 組み込みエラーハンドリングには、自動リトライロジックとエラー管理が含まれ複雑さを軽減します。 型安全性により、入力および出力スキーマがワークフローノード間でのデータ互換性を維持することが保証されます。 ドキュメントには、各ツールの使用例と詳細なパラメータ説明が含まれています。エラーハンドリングとリトライ

外部サービスに依存するツールの堅牢なエラーハンドリングを設定します: