モデルの統合

AWS Bedrock からモデルを統合する

概要

AWS Bedrock マーケットプレイス は、大規模な言語モデル (LLMs) をデプロイするための総合的なプラットフォームです。開発者は、このプラットフォームを活用して、100 を超える新興の基盤モデル (FMs) を無断配布で検出、テスト、デプロイすることができます。 本文は、DeepSeek モデルのデプロイを例として、Bedrock Marketplace プラットフォーム上でモデルをデプロイし、Dify プラットフォームに統合する方法を説明します。これにより、DeepSeek モデルを基盤とした AI アプリケーションの迅速な構築をサポートします。前提条件

- Bedrock にアクセスできる AWS アカウント。

- Dify.AI アカウント。

デプロイ手順

1. DeepSeek モデルをデプロイする

1.1 モデルの検索と選択

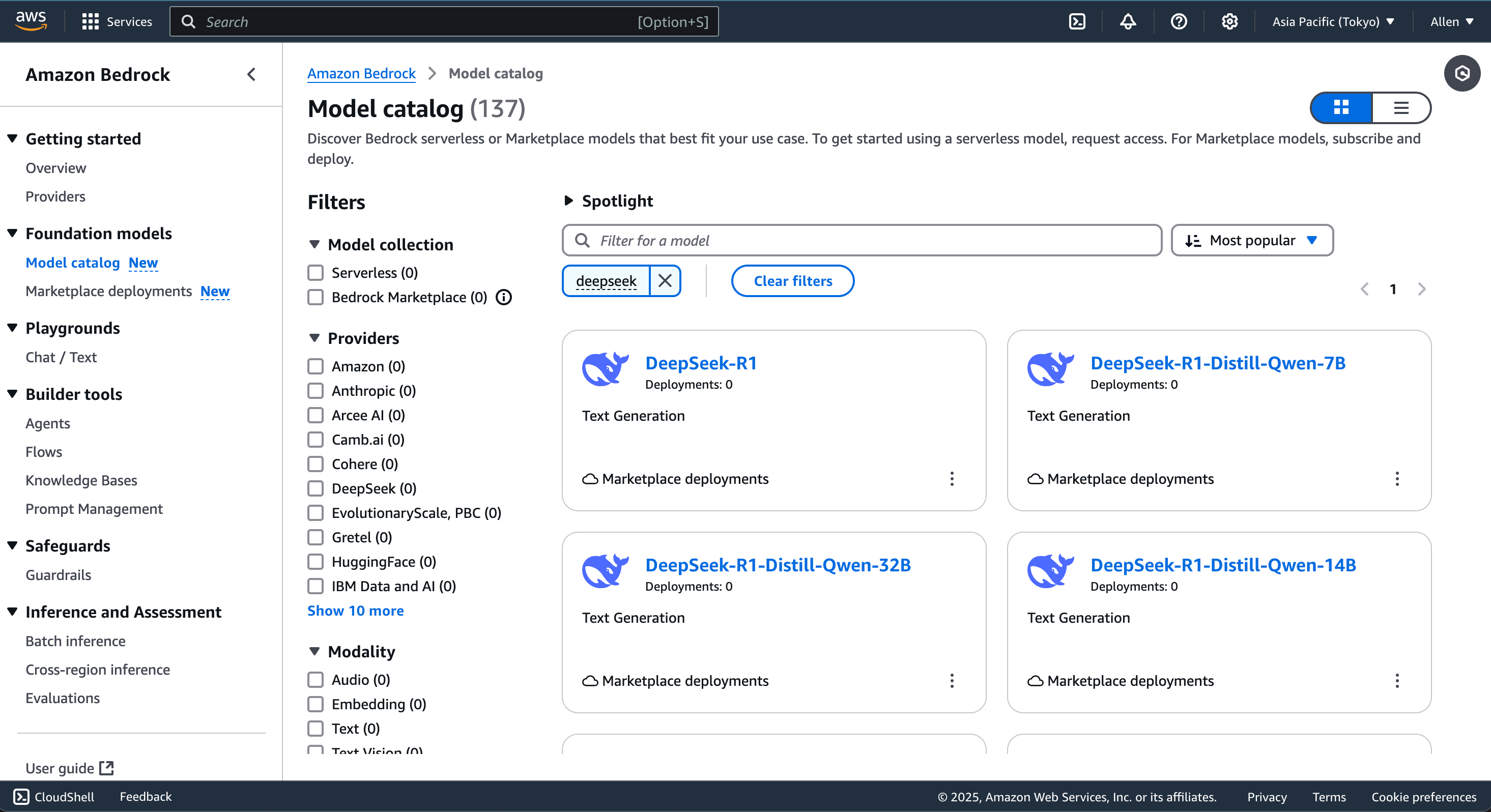

- Bedrock マーケットプレイス に移動し、DeepSeek を検索します。

- 要求に基づいて DeepSeek モデルを選択します。

1.2 デプロイの開始

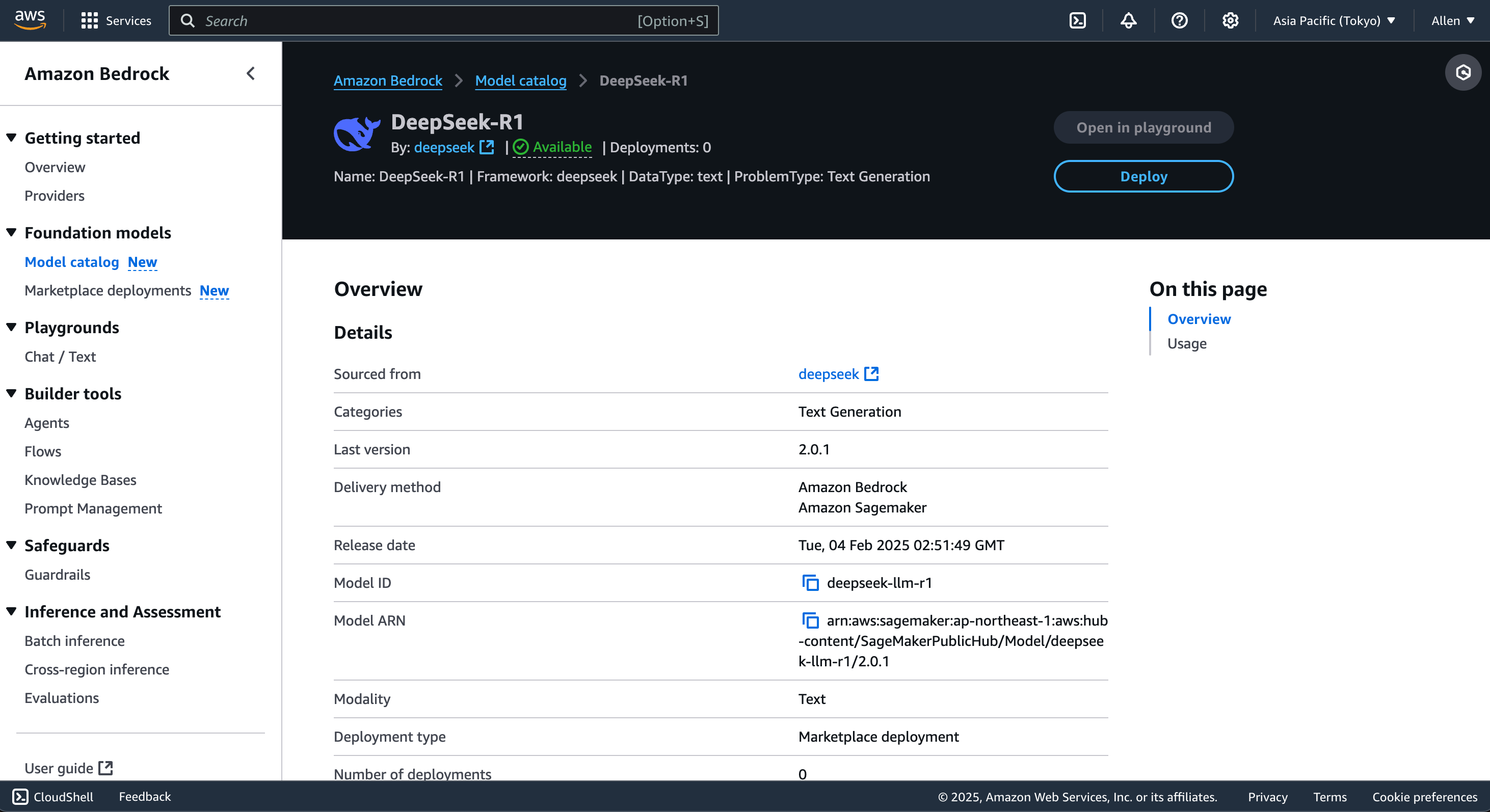

- モデル詳細 ページに移動し、デプロイ をクリックします。

- デプロイ設定を構成するための指示に従います。

注意:

モデルバージョンは異なるコンピューティング構成を必要とします。これはコストに影響します。

1.3 エンドポイントの取得

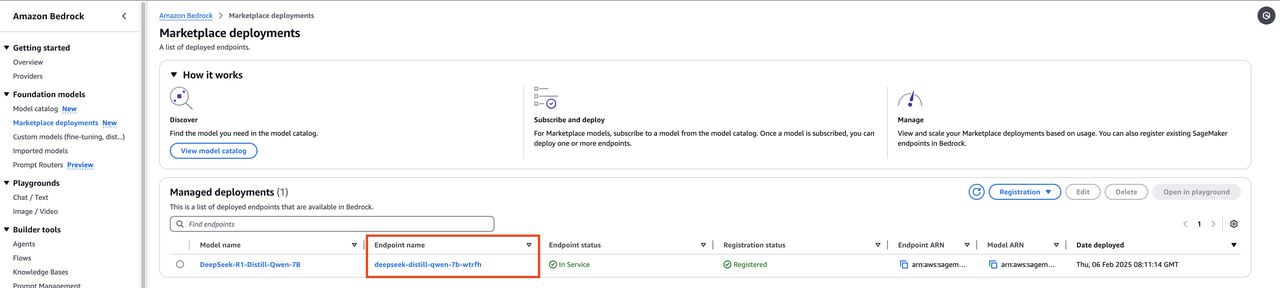

デプロイが完了したら、Marketplace Deployments ページに移動し、自動生成された Endpoint を確認します。このエンドポイントは、SageMaker エンドポイント に相当し、Dify プラットフォームに接続するために使用されます。

2. DeepSeek を Dify プラットフォームに接続する

2.1 構成設定にアクセスする

- Dify 管理パネルにログインし、設定 ページに移動します。

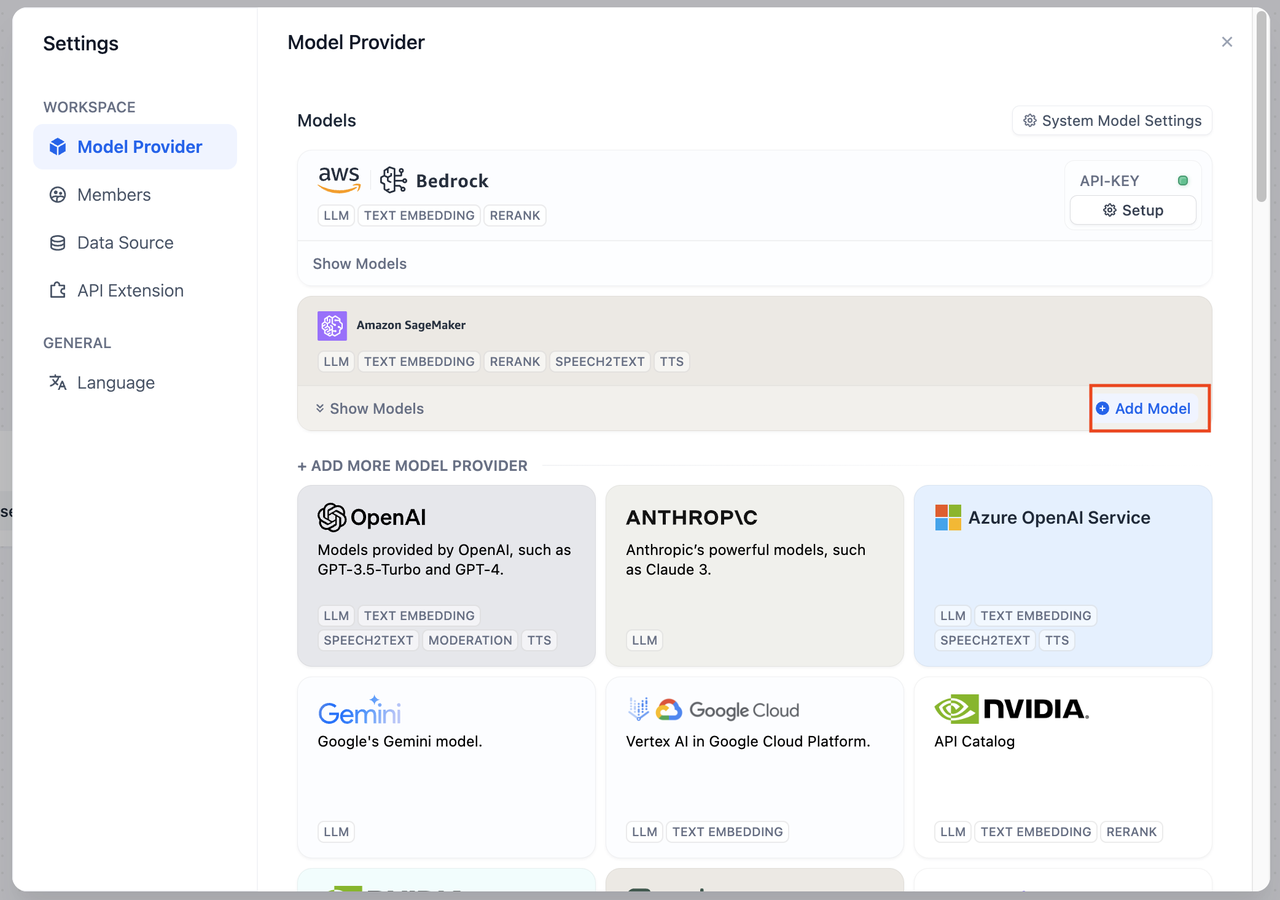

- モデルプロバイダー ページで、Amazon SageMaker を選択します。

2.2 SageMaker 設定の構成

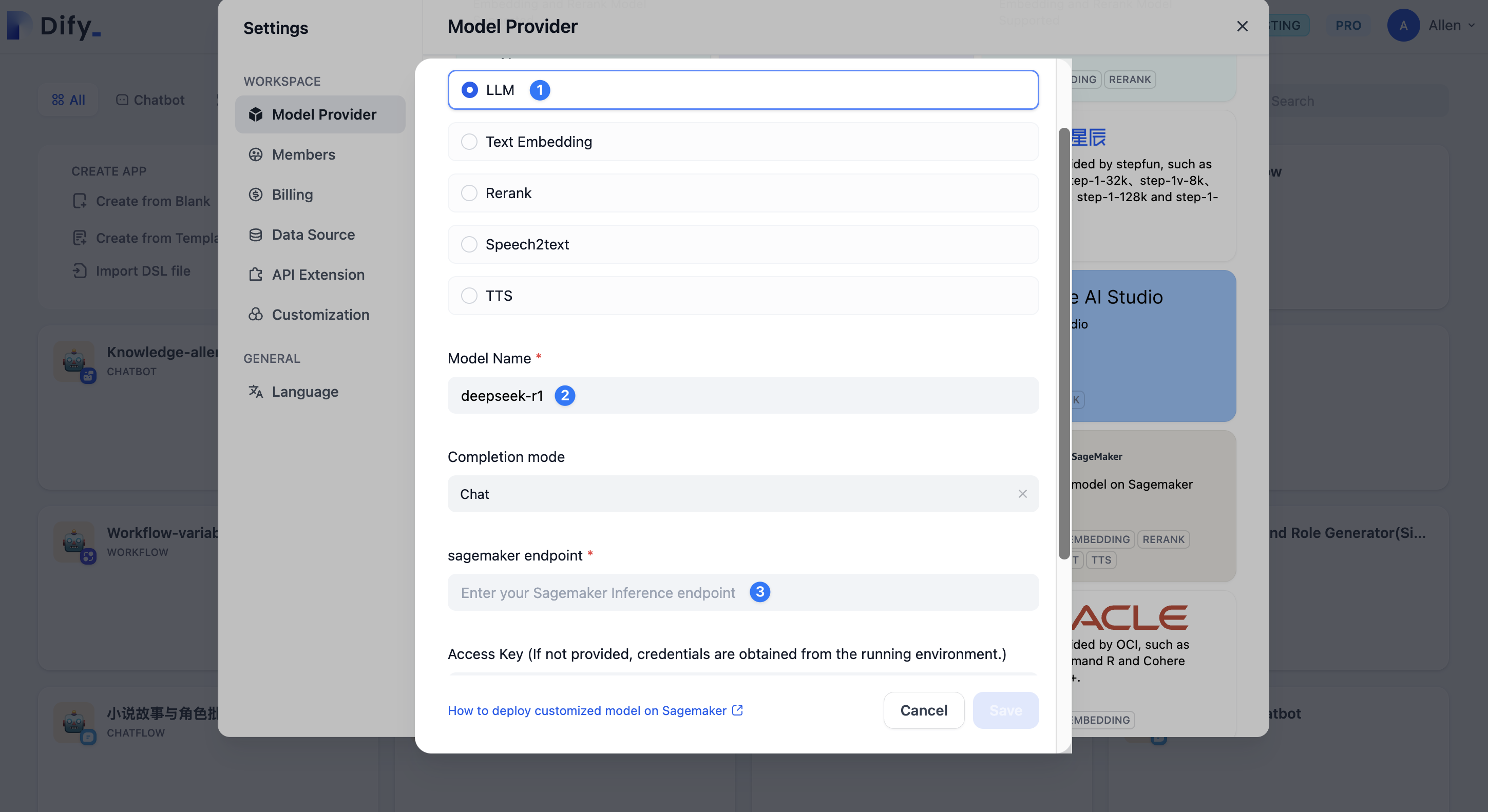

モデルを追加 をクリックし、以下の情報を入力します:- モデルタイプ: モデルタイプとして LLM を選択します。

- モデル名: モデルにカスタム名を指定します。

- SageMaker エンドポイント: Bedrock マーケットプレイスから取得したエンドポイントを入力します。

3. モデルのテスト

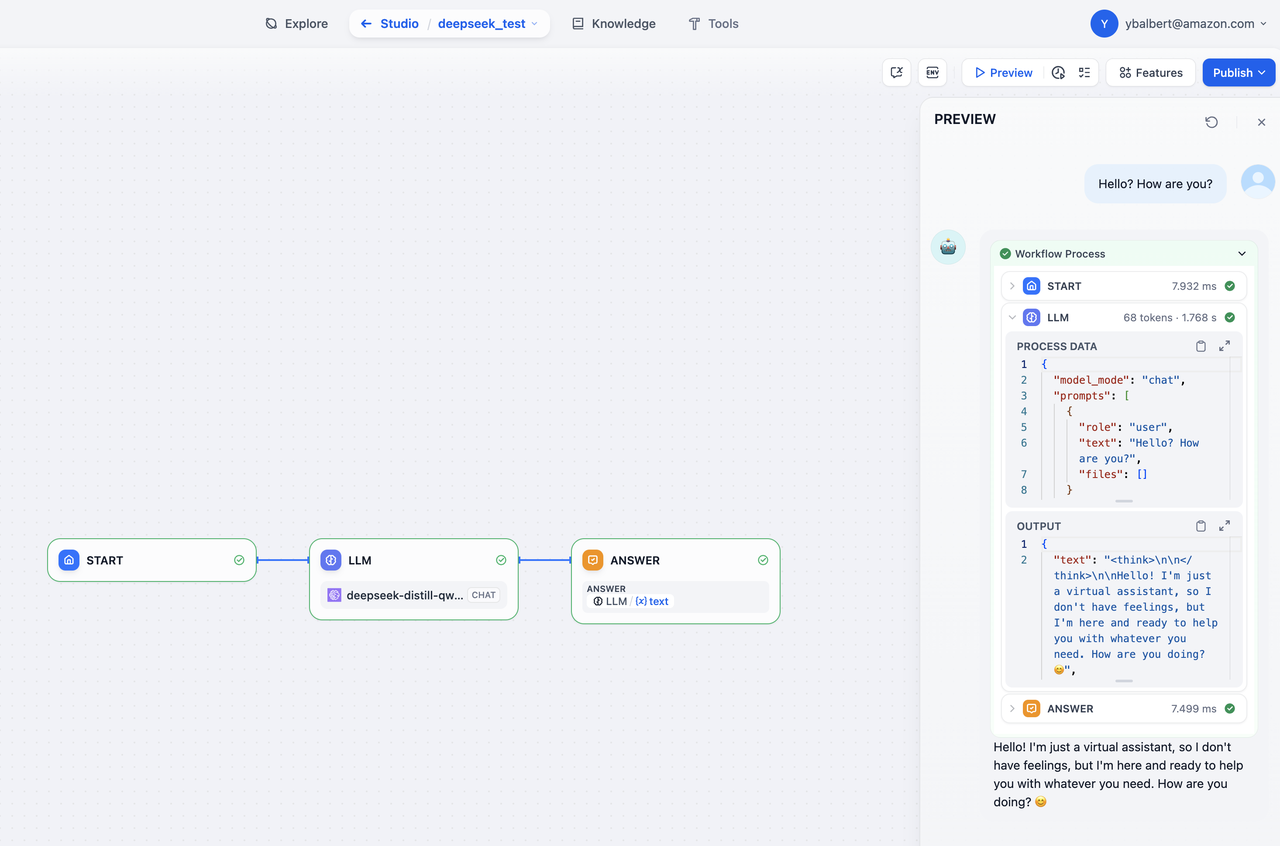

- Dify を開き、新しいアプリを作成 を選択します。

- チャットフロー または ワークフロー を選択します。

- LLM ノードを追加します。

- モデルの応答を確認します (以下のスクリーンショット参照)。

注意:

追加のテストとして、チャットボット アプリケーションを作成することもできます。

FAQ

1. デプロイ後にエンドポイント パラメータが表示されない

コンピューティング インスタンスが正しく構成され、AWS のパーミッションが適切に設定されていることを確認します。如果問題が解決しない場合は、モデルを再デプロイするか、AWS カスタマー サポートに連絡してください。このページを編集する | 問題を報告する