⚠️ 本文档由 AI 自动翻译。如有任何不准确之处,请参考英文原版。

本内容涵盖在 Dify 中使用 MCP 工具。要将 Dify 应用程序发布为 MCP 服务器,请参阅这里。

目前仅支持使用 HTTP 传输 的 MCP 服务器。

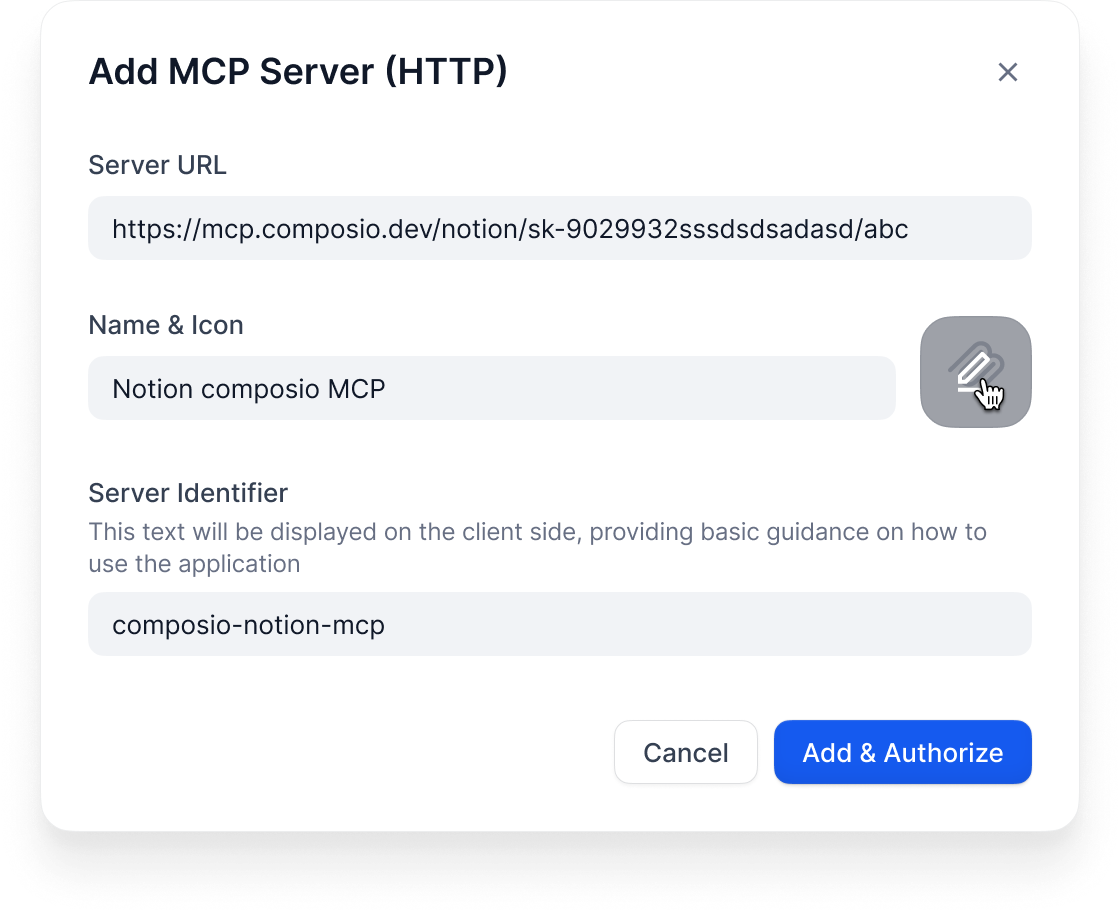

添加 MCP 服务器

在你的工作空间中转到工具 → MCP。

https://api.notion.com/mcp)

名称和图标:给它一个有用的名称。Dify 会尝试自动获取图标。

服务器 ID:唯一标识符(小写字母、数字、下划线、连字符,最多 24 个字符)

接下来会发生什么

Dify 会自动:- 连接到服务器

- 处理任何 OAuth 认证

- 获取可用工具列表

- 使它们在你的应用程序构建器中可用

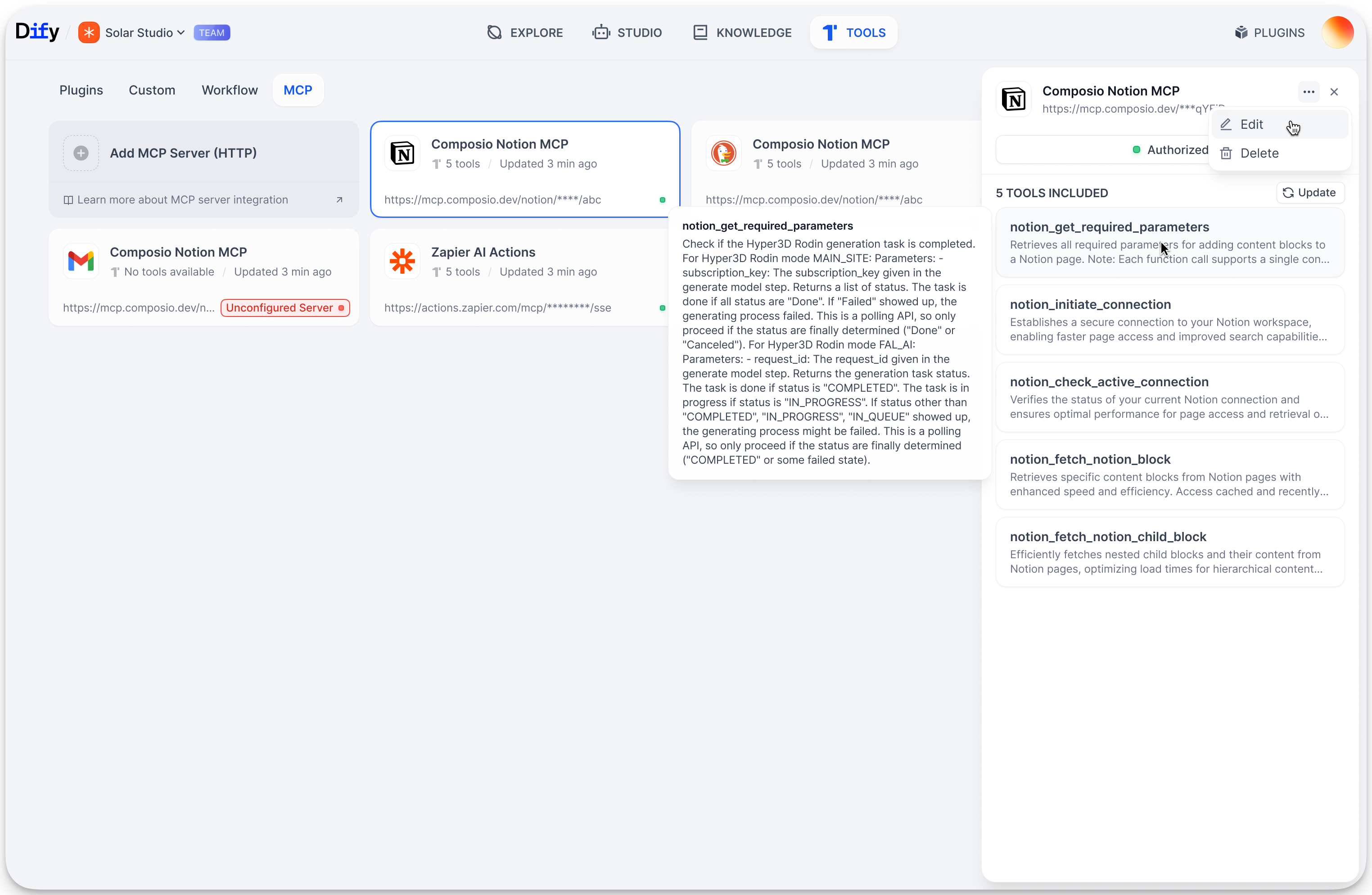

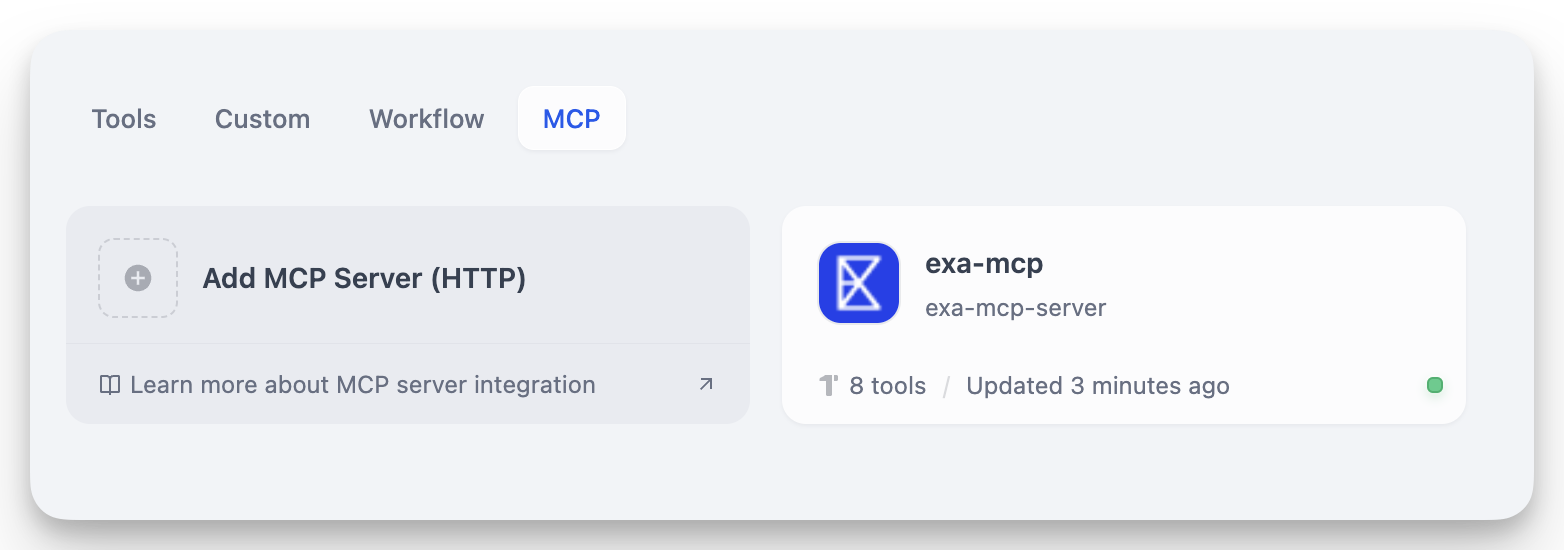

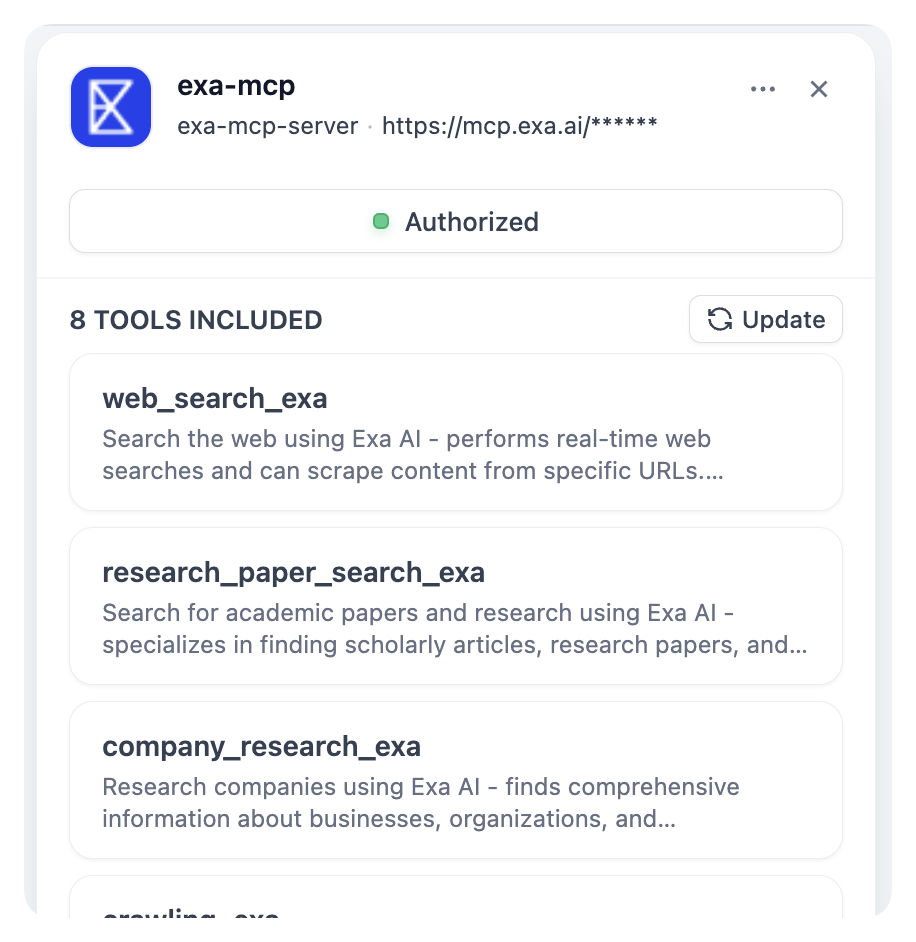

管理服务器

点击任何服务器卡片可以: 更新工具:当外部服务添加新工具时刷新

使用 MCP 工具

连接后,MCP 工具会出现在你期望的所有地方: 在智能代理中:工具按服务器分组显示(“Notion MCP » Create Page”) 在工作流中:MCP 工具作为节点可用 在智能代理节点中:与常规智能代理相同自定义工具

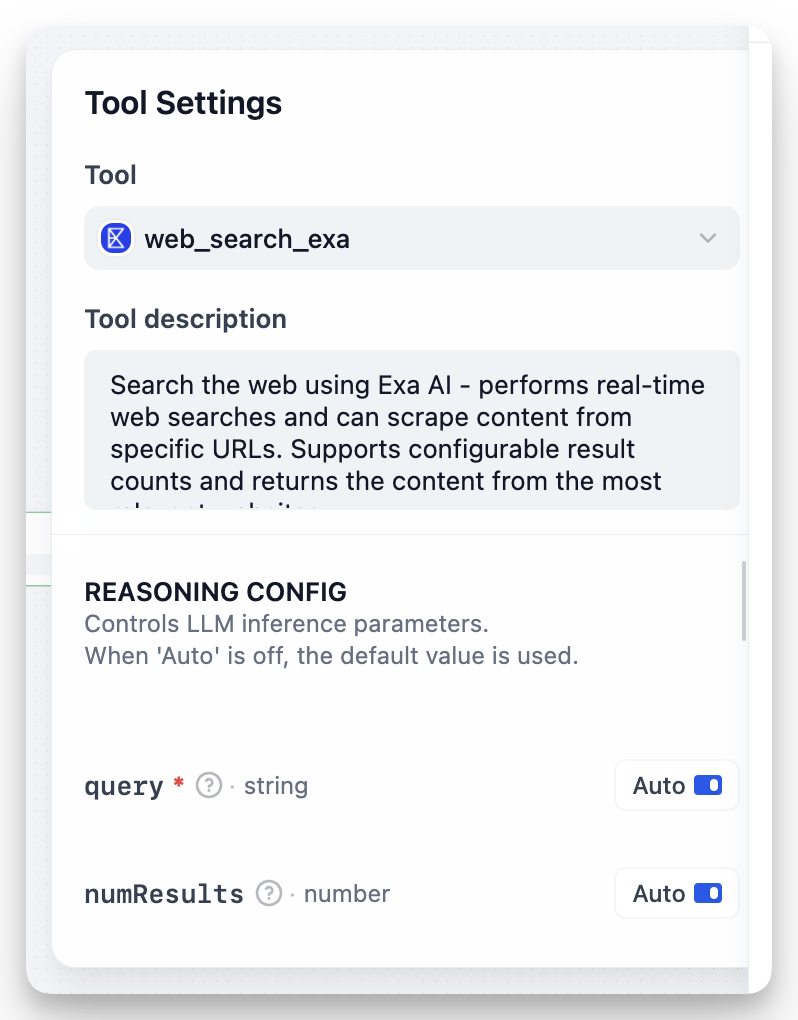

添加 MCP 工具时,你可以自定义它:

- 自动:让 AI 决定值

- 固定:设置一个永不改变的特定值

numResults 设置为 5(固定),但保持 query 为自动。

分享应用程序

当你导出使用 MCP 工具的应用程序时:- 导出内容包含服务器 ID

- 要在其他地方使用该应用程序,需要添加具有相同 ID 的相同服务器

- 记录你的应用程序需要哪些 MCP 服务器

故障排除

“未配置的服务器”:检查 URL 并重新授权 缺少工具:点击”更新工具” 应用程序损坏:你可能更改了服务器 ID。使用原始 ID 重新添加它。提示

- 使用永久的、描述性的服务器 ID,如

github-prod或crm-system - 在开发/测试/生产环境中保持相同的 MCP 设置

- 为配置项设置固定值,为部署前测试 MCP 集成