モデルタイプ

Difyでは、使用シーンに応じてモデルを4つのタイプに分類しています:-

システム推論モデル。アプリケーション内で使用されるのはこのタイプのモデルです。チャット、会話名生成、次の質問の提案でもこの推論モデルが使用されます。

サポートされているシステム推論モデルプロバイダー:OpenAI、Azure OpenAIサービス、Anthropic、Hugging Faceハブ、Replicate、Xinference、OpenLLM、讯飞星火、文心一言、通义千问、Minimax、ZHIPU(ChatGLM)

-

Embedding モデル。データセット内の分割された文書の埋め込みに使用されるのはこのタイプのモデルです。データセットを使用するアプリケーションでは、ユーザーの質問を埋め込み処理する際にもこのタイプのモデルが使用されます。

サポートされているEmbedding モデルプロバイダー:OpenAI、ZHIPU(ChatGLM)、Jina AI(Jina Embeddings)

-

Rerankモデル。Rerankモデルは検索能力を強化し、LLMの検索結果を改善するために使用されます。

サポートされているRerankモデルプロバイダー:Cohere、Jina AI(Jina Reranker)

-

音声からテキストへのモデル。対話型アプリケーションで音声をテキストに変換する際に使用されるのはこのタイプのモデルです。

サポートされている音声からテキストへのモデルプロバイダー:OpenAI

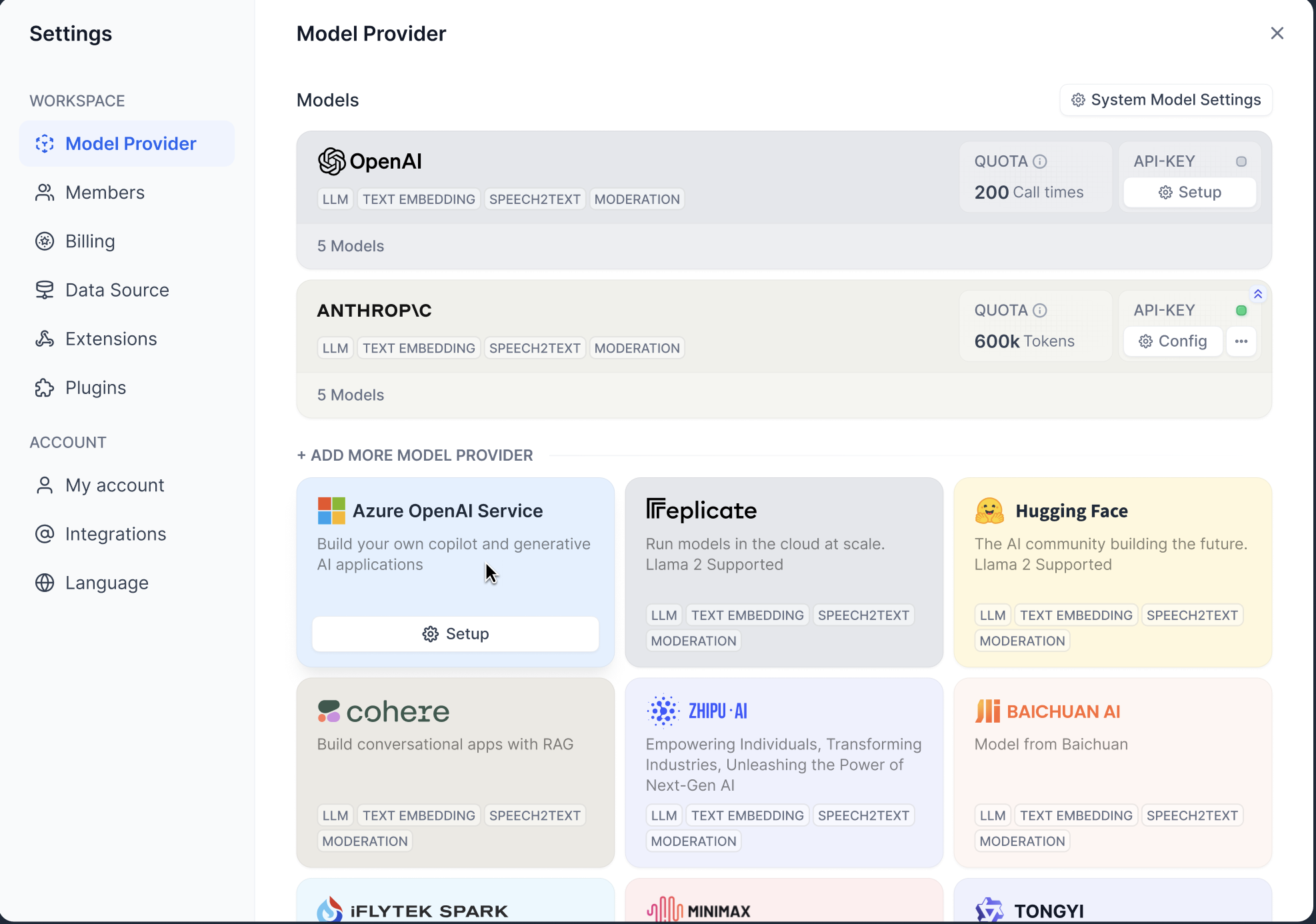

ホストモデル試用サービス

Difyクラウドサービスのユーザーには、異なるモデルの無料利用枠を提供しています。無料利用枠の範囲を超えるとアプリケーションの正常な使用に影響を及ぼす可能性がありますのでその前に自分のモデルプロバイダーを設定してください。- OpenAIホストモデル試用: GPT3.5-turbo、GPT3.5-turbo-16k、text-davinci-003モデルの試用として200回までの無料で呼び出すことが可能です。

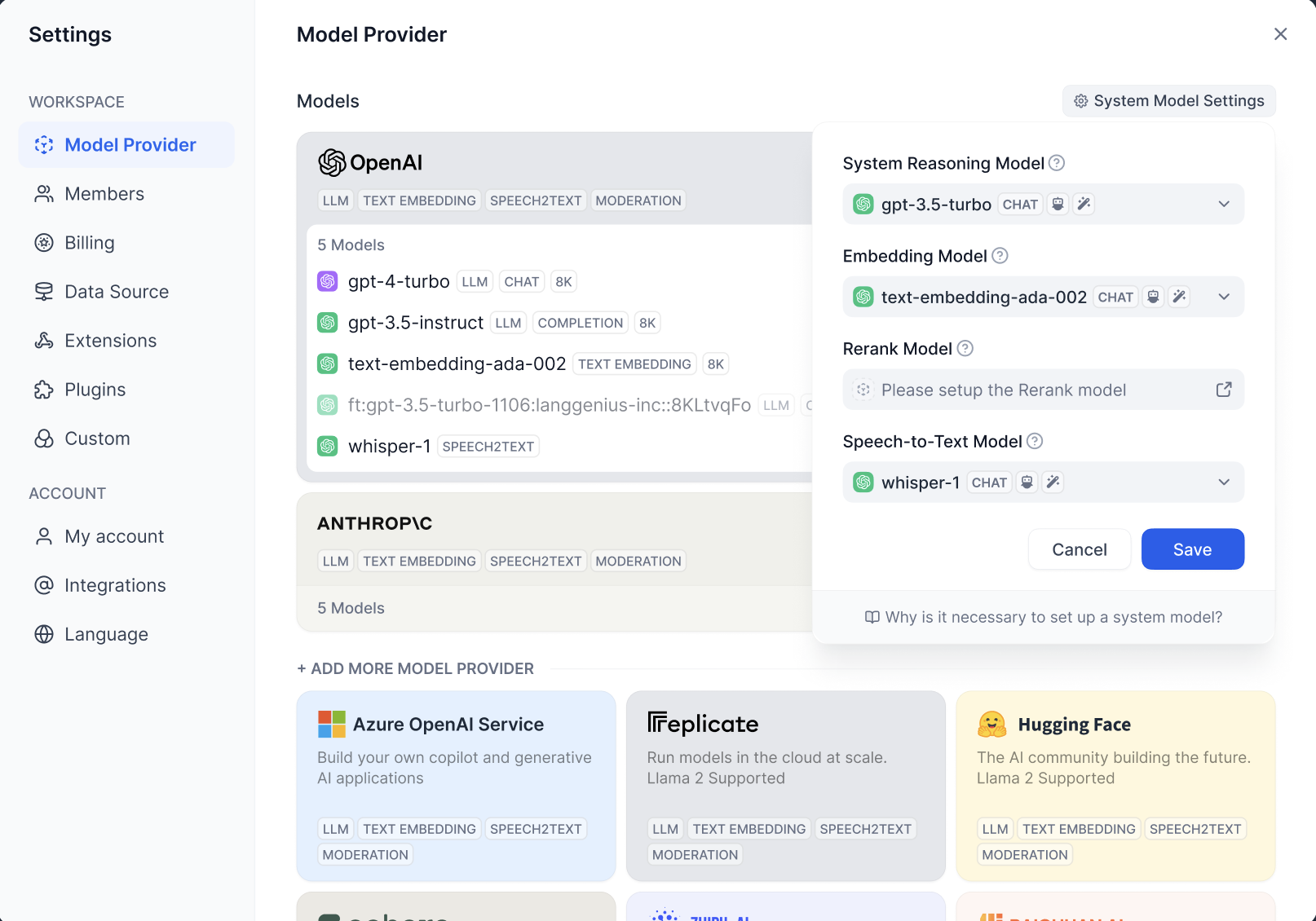

デフォルトモデルの設定

Difyは使用シーンに応じて設定されたデフォルトモデルを選択します。設定 > モデルプロバイダーでデフォルトモデルを設定します。

モデルの接続設定

Difyの設定 > モデルプロバイダーで接続するモデルを設定します。

- 自社モデル。このタイプのモデルプロバイダーは自社で開発したモデルを提供します。例としてOpenAI、Anthropicなどがあります。

- ホストモデル。このタイプのモデルプロバイダーは第三者のモデルを提供します。例としてHugging Face、Replicateなどがあります。

DifyはPKCS1_OAEPを使用してユーザーが管理するAPIキーを暗号化して保存しています。各テナントは独立したキーペアを使用して暗号化しているので、APIキーの漏洩を防ぐことができます。

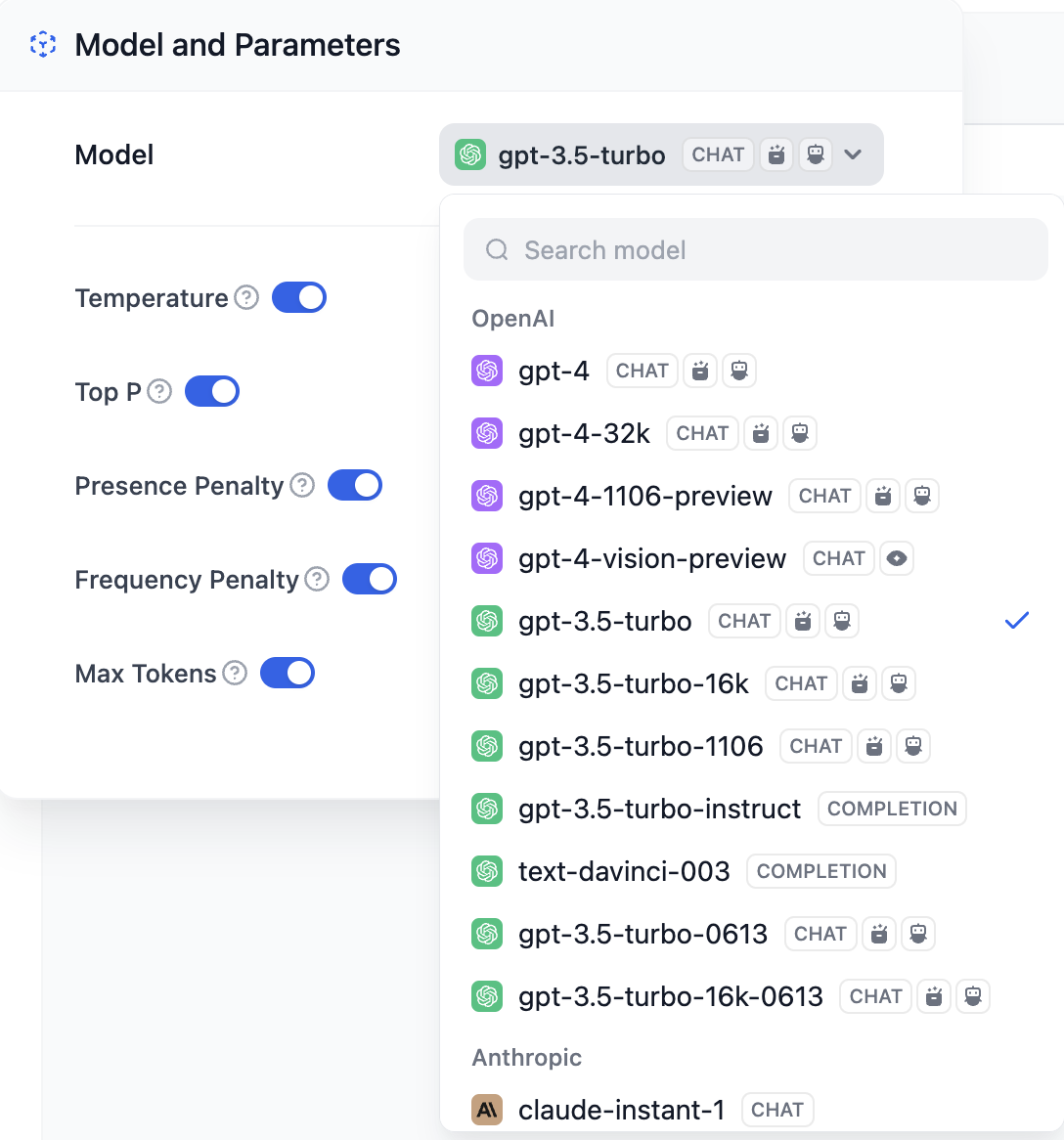

モデルの使用

モデルの設定が完了したら、アプリケーションでこれらのモデルを使用できます: