⚠️ 本文档由 AI 自动翻译。如有任何不准确之处,请参考英文原版。

工具类型

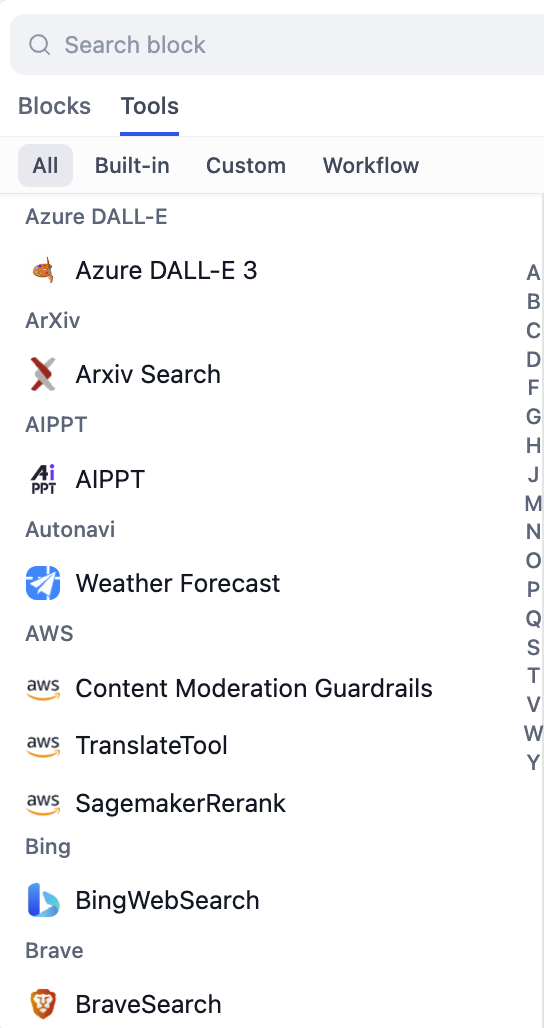

Dify支持多种类型的工具来处理不同的集成需求:

- 内置工具

- 自定义工具

- 工作流工具

- MCP工具

由Dify维护的即用型集成,适用于包括Google Search、天气API、生产力工具和AI服务在内的流行服务。这些工具需要最少的配置,并提供可靠、经过测试的集成。

配置

身份验证

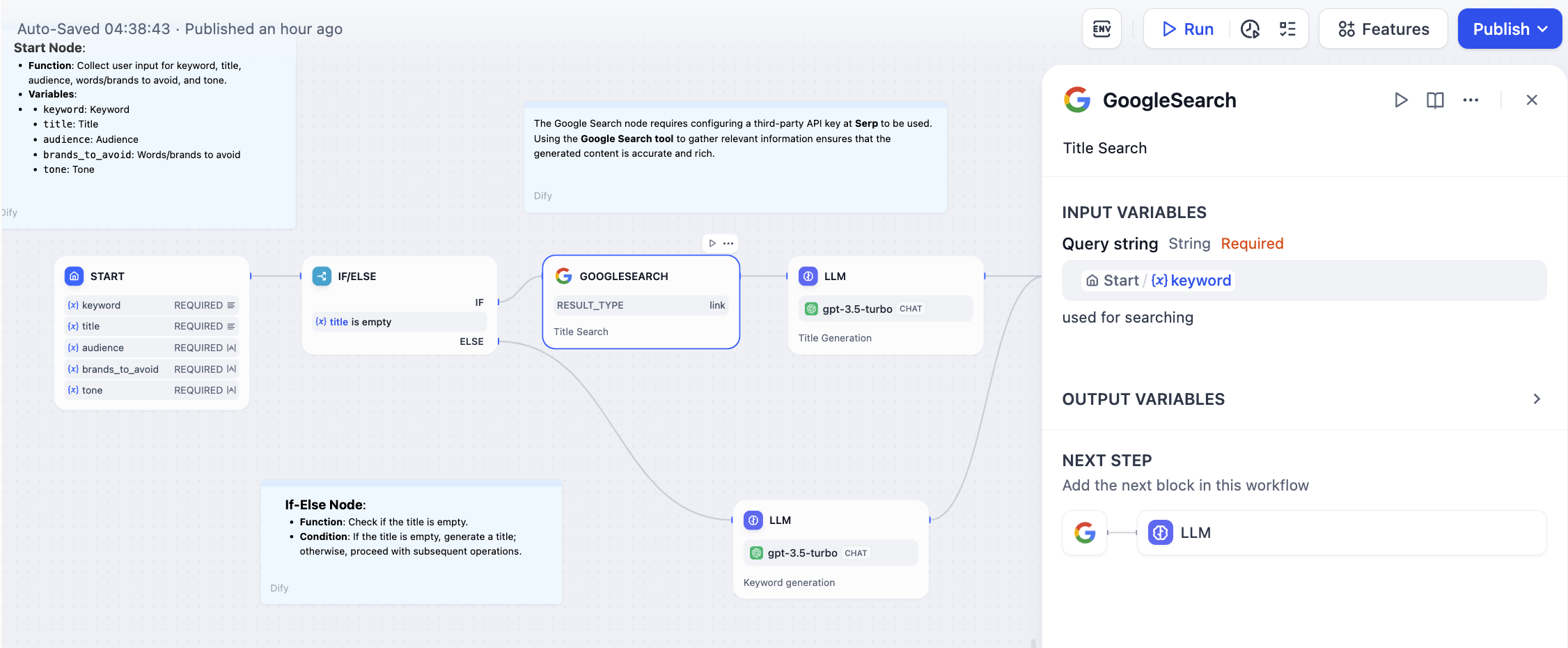

许多工具需要API密钥或OAuth身份验证。在工作流中使用这些工具之前,请在你工作空间的工具部分配置这些凭据。配置完成后,身份验证将自动处理。输入参数

工具提供带有验证的结构化表单用于输入配置。使用来自之前工作流节点的变量设置参数。界面自动处理数据类型验证,并为每个参数提供有用的描述。输出处理

工具返回结构化数据,这些数据作为变量可用于下游节点。输出模式是预定义的,确保兼容性并降低集成复杂性。相比HTTP请求的优势

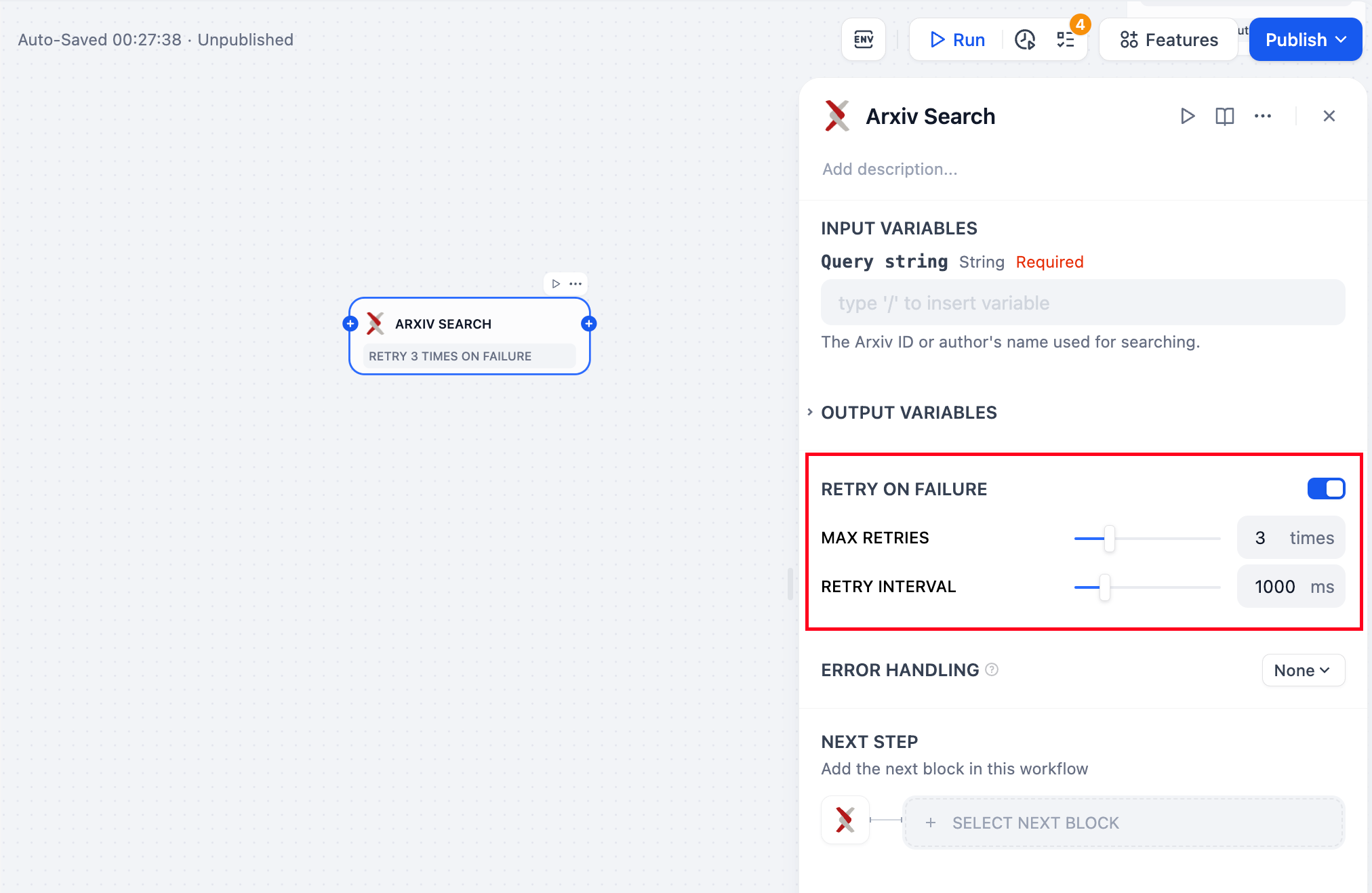

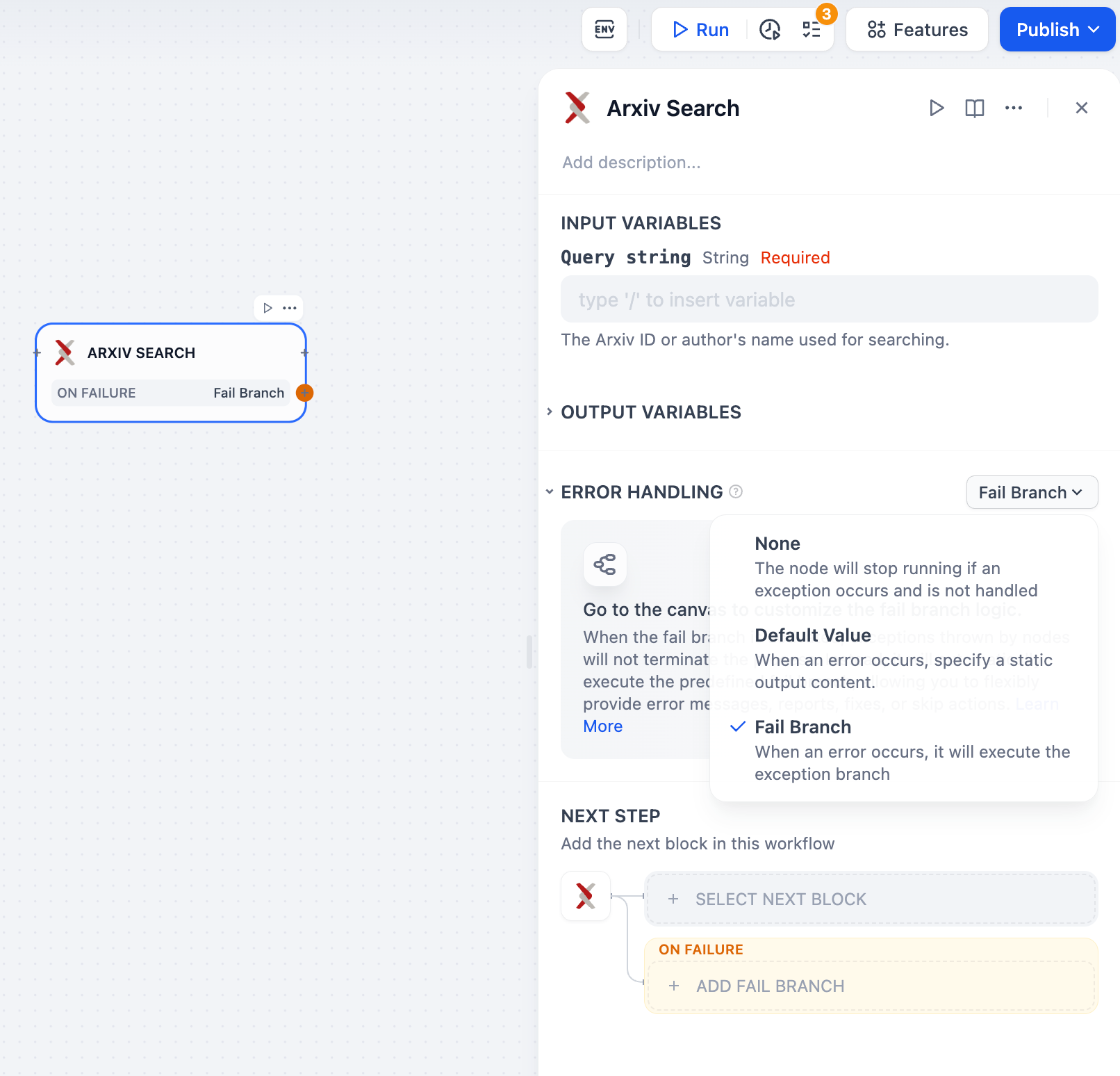

结构化接口提供基于表单的配置和内置验证,使设置比手动HTTP请求配置更容易。 内置错误处理包括自动重试逻辑和错误管理,降低了处理API故障的复杂性。 类型安全确保输入和输出模式在工作流节点之间保持数据兼容性。 文档为每个工具包含使用示例和详细的参数描述。错误处理和重试

为依赖外部服务的工具配置强大的错误处理: