步骤 1:创建新工作流(2 分钟)

- 前往 工作室 > 工作流 > 从空白创建 > 编排 > 新建对话流 > 创建

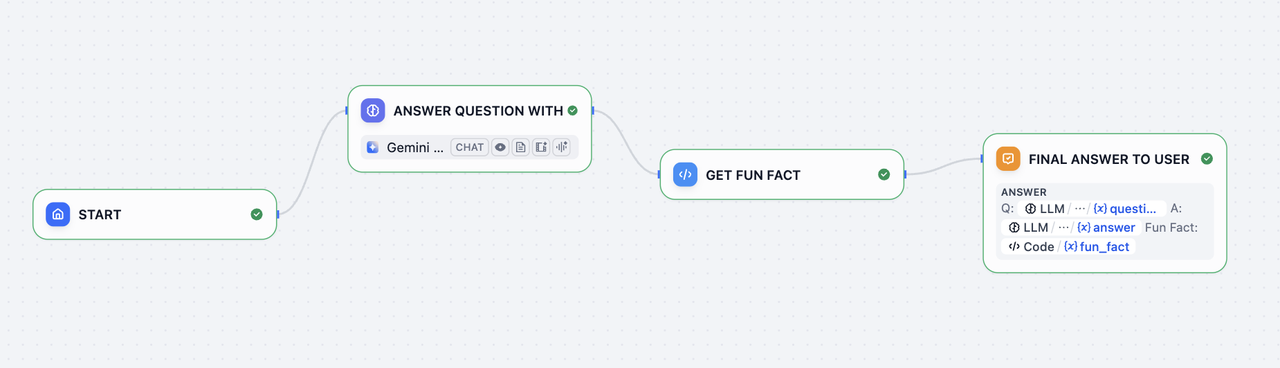

步骤 2:添加工作流节点(6 分钟)

1. LLM 节点和输出:理解并回答问题

LLM 节点向语言模型发送提示词,根据用户输入生成响应。它抽象了 API 调用、速率限制和基础设施的复杂性,让你可以专注于设计逻辑。1

创建 LLM 节点

使用

添加节点 按钮创建一个 LLM 节点,并将其连接到起始节点2

配置模型

选择一个默认模型

3

设置系统提示词

将以下内容粘贴到系统提示词字段:

4

启用结构化输出

启用结构化输出 让你可以轻松控制 LLM 返回的内容,确保输出一致且机器可读,用于下游的精确数据提取或条件逻辑。

- 将输出变量结构化切换为开启 >

配置并点击从 JSON 导入 - 粘贴:

2. 代码块:获取趣事

代码 节点使用代码执行自定义逻辑。它让你可以在需要的确切位置注入代码——在可视化工作流中——让你无需搭建整个后端。1

创建代码节点

使用

添加节点 按钮创建一个 代码 节点,并连接到 LLM 块2

配置输入变量

将一个

输入变量 名称改为 “country”,并将变量设置为 structured_output > country3

添加 Python 代码

将此代码粘贴到

PYTHON3:4

重命名输出变量

将输出变量

result 改为 fun_fact 以获得更好标记的变量3. 答案节点:给用户的最终答案

答案 节点创建一个简洁的最终输出返回给用户。1

创建答案节点

使用

添加节点 按钮创建一个 答案 节点2

配置答案字段

粘贴到答案字段:

步骤 3:测试机器人(3 分钟)

点击预览,然后询问:

- “法国的首都是什么?”

- “给我介绍一下日本料理”

- “描述一下意大利的文化”

- 任何其他问题